EXO Labs在Windows 98旧版操作系统上成功运行了大模型。这一电脑硬件配置相对较低,却达成了这一显著成就。这一成果显著,对传统关于电脑性能和大模型运行环境的认知提出了挑战。

古老电脑启动大冒险

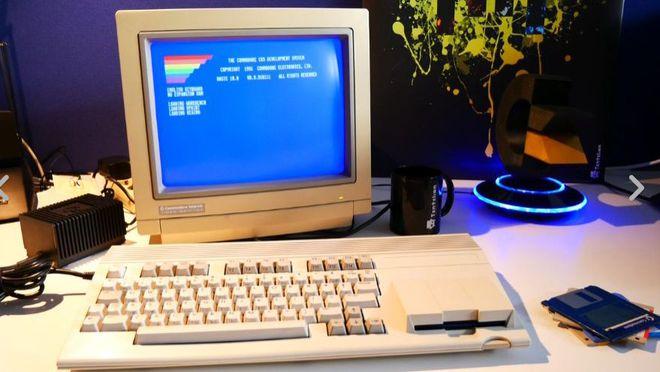

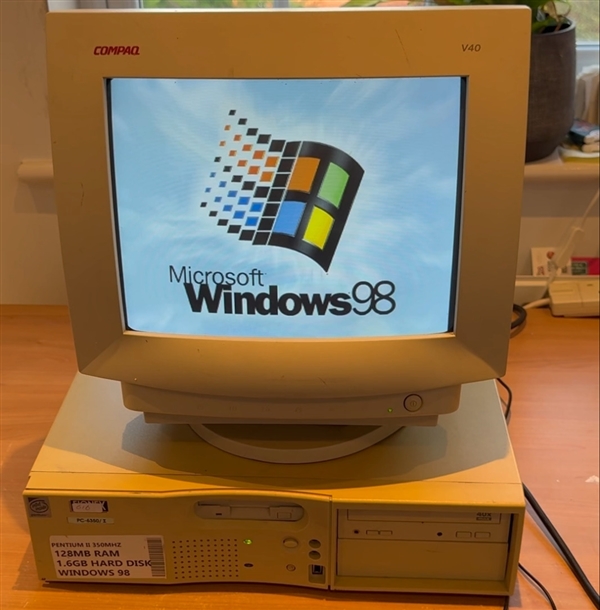

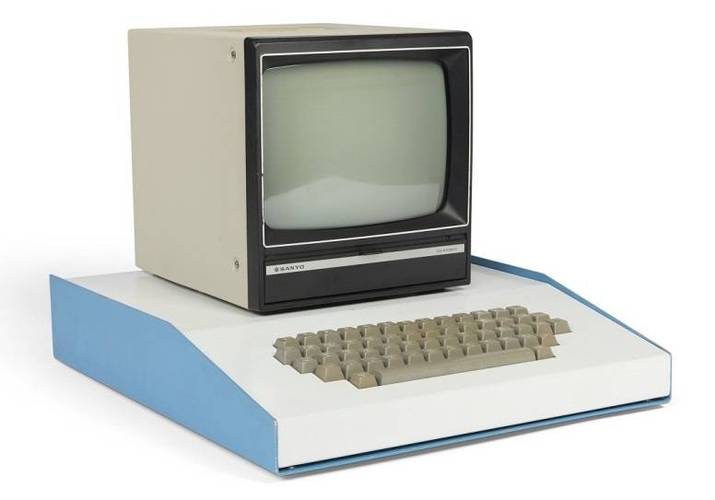

12月30日,EXO Labs公布了一则信息。一台26岁的Windows 98奔腾2电脑被选中,其处理器频率仅为350MHz。该电脑顺利进入了Windows 98操作系统,并启动了专门的引擎来运行大型模型。这一过程充满挑战,老旧设备在运行过程中遇到了众多困难,但EXO Labs最终成功解决了这些问题。这一成就表明,即使硬件条件十分落后,依然有潜力运行大型模型。老式电脑并非不能适应新技术,关键在于如何巧妙地应用技术。

该事件揭示了硬件配置并非不可克服的难题。众多创新思维和科技手段已成功实现了看似不可能的目标,比如在旧电脑上运行大型模型。这种做法或许能为资源有限的群体或地区带来新的启示。

EXO Labs的使命

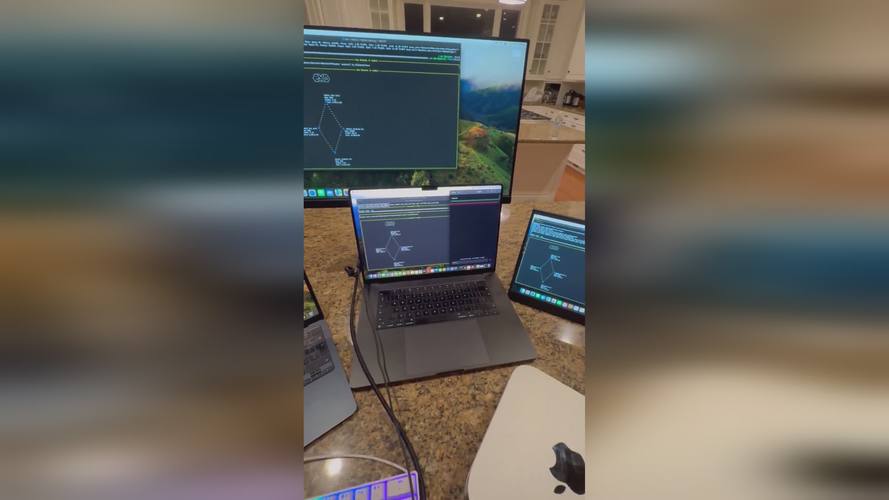

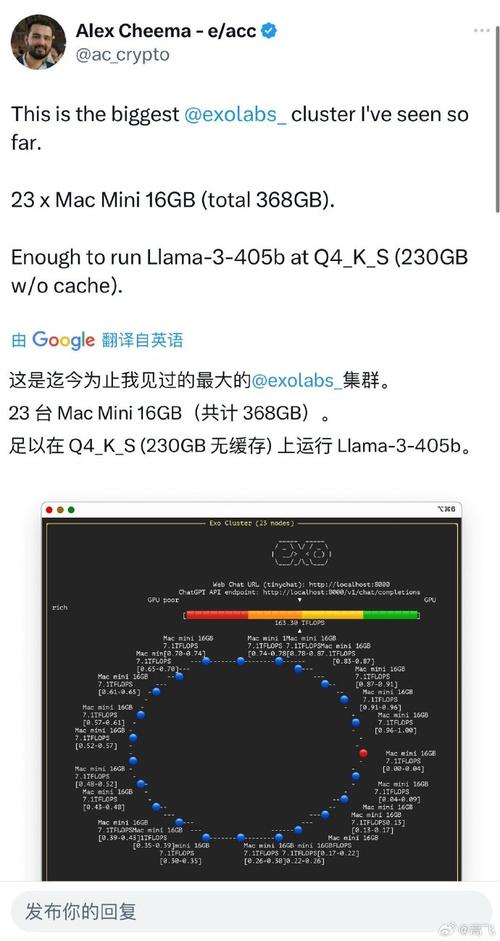

牛津大学的研究员与工程师组成了EXO Labs团队,该团队秉持“AI民主化”的核心宗旨。他们强调,少数大型企业对人工智能的垄断在多个社会领域造成了不良影响。

他们专注于构建开放的基础设施,着力发展前沿模型,目标是为用户无论身处何地都能提供流畅的使用体验。这一理念对现有的AI产业格局提出了挑战,他们追求打破行业壁垒,使AI技术能够更普遍地服务于大众,并吸引更多人士加入AI技术的研发和应用领域。

过程中的挑战

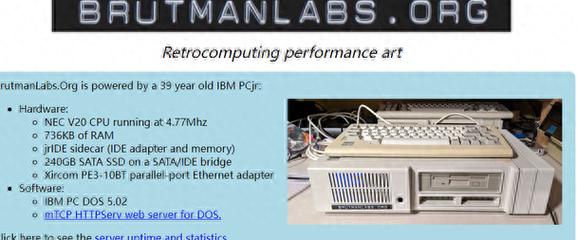

EXO Labs在项目执行阶段面临诸多挑战。初期,数据传输环节出现难题,特别是针对老旧设备的数据传输问题突出。为此,他们转而使用陈旧的FTP协议,并通过以太网端口完成文件传输。

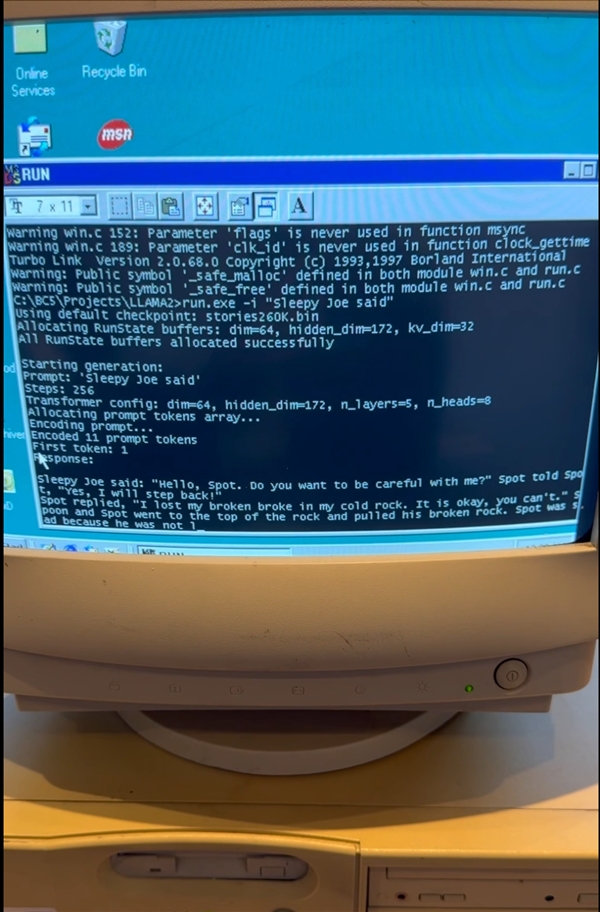

代码编译阶段遭遇了众多难题,特别是确保当代代码能在Windows 98操作系统上运行。所幸的是,他们找到了Andrej Karpathy的llama2.c资源。利用Borland C++ 5.02集成开发环境及编译器,经过适当调整,他们成功制作出了适用于Windows 98的执行文件。该代码的完整版本可在GitHub上查找到。

不同LLM下的速度表现

在项目实施过程中,不同规模的LLM模型呈现了各异的处理效率。以260K规模的LLM模型为例,当与Llama架构搭配,运行于Windows 98系统时,其处理速度可达每秒35.9个token。

自升级至15M LLM版本以来,其生成速度略高于1 tok/s。与此同时,Llama 3.2 1B的速度则大幅降低,降至0.0093 tok/s。这一变化充分显示出,LLM的规模对传统系统中的运行速度有显著作用。尽管如此,在现有硬件配置下,仍能保持如此速度,实属令人赞叹。

意义非凡的示范

该成果显著,凸显了即便在资源极其有限的情况下,如使用老旧电脑,也能实现人工智能相关任务。这对于那些硬件条件不足的地区或研究者来说,无疑带来了重要的启示和希望。

教育资源匮乏的地区可能配备有老旧的计算机。若此类设备用于AI的学习和研究,将极大推动AI在基层领域的普及应用。

未来的展望

EXO Labs的研究或许能为人工智能领域带来新的启示。在将来,相关技术的升级可能将更加重视对低性能硬件的适配性。

技术发展推动了如EXO Labs等机构的增加,这些机构专注于降低人工智能的入门难度。这一趋势有助于打破少数企业对人工智能领域的垄断,让人工智能更加深入地融入社会各个层面。

您如何看待EXO Labs的演示对人工智能推广的作用?期待您的观点、点赞和分享。