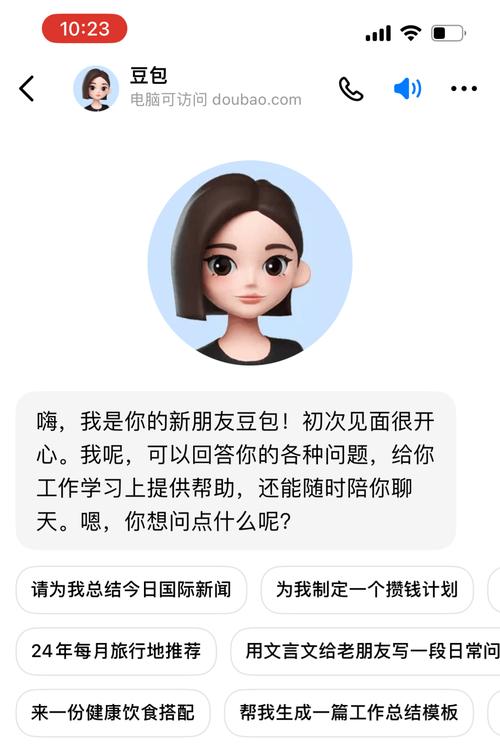

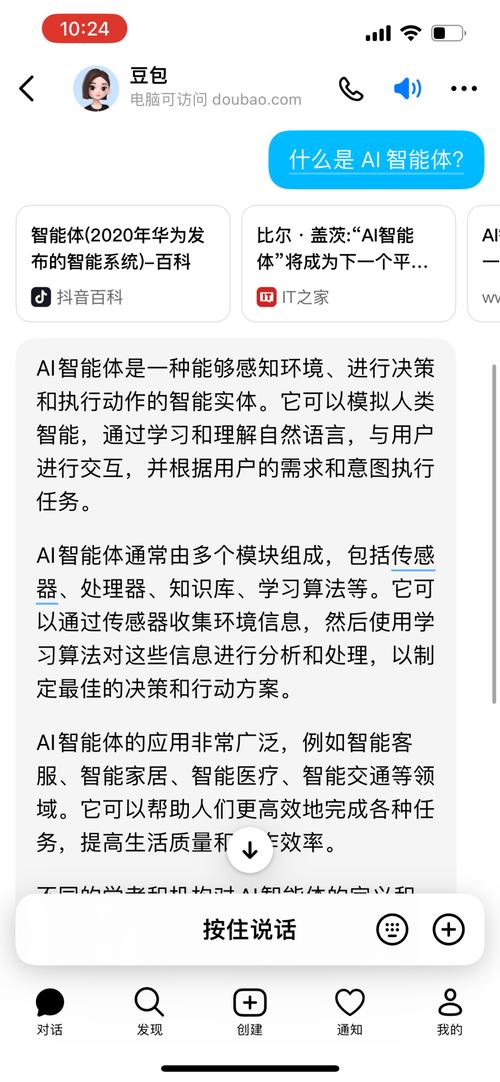

1月20日,字节跳动旗下豆包大模型团队发布重要消息。豆包实时语音大模型今日正式对外发布,引发科技界广泛关注。同时,该模型已在豆包App全面开放,用户只需升级至7.2.0版本即可体验,极大地提升了用户便利性和惊喜感。

模型特性

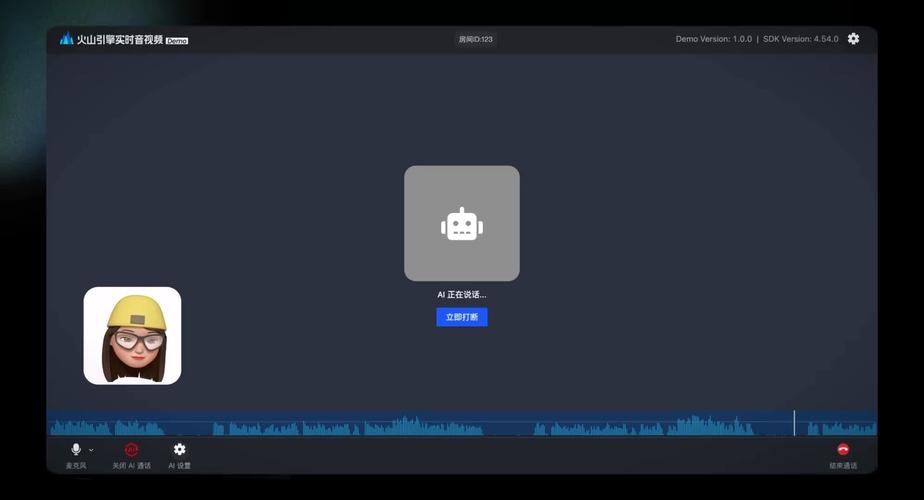

豆包实时语音大模型实现了语音理解和生成的一体化,支持端到端的语音对话。与传统的级联模式相较,该模型在语音的表现力、控制力以及情绪承接上表现出色。它具备低延迟和可中断对话等特性。这些特性凸显了其显著的技术优势,使用户能够享受到更加流畅和自然的语音交互体验。该体验得益于其背后强大的算法支撑,确保了用户与模型对话的高效性和舒适性。

该模型被誉为“情商智商兼备”,并非名不副实。其反应与处理能力展现了卓越的智能水准,有效解读用户意图并给出恰当反馈。在解读用户指令的过程中,误解与偏差现象极为罕见。

适用范围

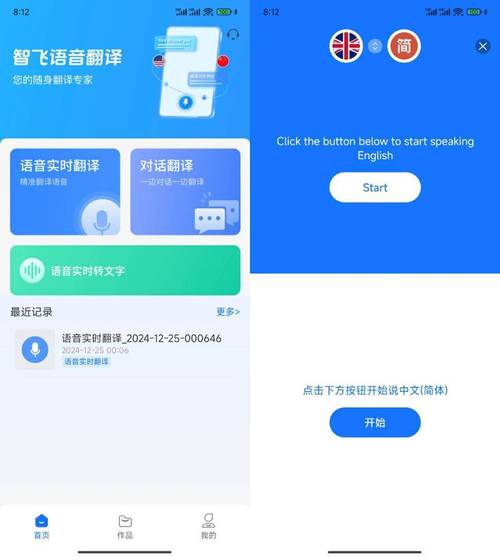

该模型主要服务于中文环境和情境,反映出字节跳动对中国市场庞大需求的积极应对。同时,该模型具备英语对话功能,然而目前尚不支持多种语言,这反映了其在开发阶段的某些限制。在中文使用环境中,该模型能够提供优质的服务。

目前,从地域和语言层面分析,模型仅能识别有限的地域方言及地方口音。尽管如此,这一进展值得肯定。展望未来,随着技术的不断进步,模型有望拓展对更多语言和方言的识别能力。

联合建模成果

模型结合语音与语义进行建模,展现出丰富的表现力,其语音表达水平接近真实人类。例如,在叙述故事时,模型能够生动地转换角色与情感,使故事更具吸引力。此功能显著增强了用户的互动乐趣和沉浸体验。

联合建模使得模型展现出超越预期的功能,包括对指令的解析、声音模仿及声音操控。该模型能够应对某些未经特定方言和口音训练的语料,这主要归功于Pretrain阶段数据所具备的良好泛化能力。

语音效果逼近真人

模型生成的语音在表现力上与人类极为相似,具备了类似人类的辅助语言特征,例如语气词和思考时的停顿。这种与真人相近的语音效果,显著提升了对话的自然度。

模型具备实时网络连接能力,有效应对时效性挑战。技术演示中,其语音的自然流畅度与情绪饱满度接近人类,对话形式更具人性化,对情感的领悟更为透彻,在捕捉用户情绪方面表现出色。

现有的局限性

豆包实时语音大模型的表现令人瞩目,然而,其局限性同样不容忽视。当前,该模型主要针对中文提供支持,而对其他语言的覆盖尚不充分,这一限制影响了其国际化的推广。此外,即便在中文领域,对方言和口音的适应性也有待提升,众多地区的方言和特定口音仍难以得到准确处理,这是字节跳动团队未来需解决的关键挑战。

未来展望

字节跳动旗下的豆包大模型团队将持续优化升级这一实时语音模型。技术进步之下,我们对其扩展更多语言支持抱有信心,它或许能在全球语音交互领域扮演关键角色。对多样方言和口音的适应能力亦将逐步提升。豆包实时语音大模型未来可能带来更多惊喜,为用户提供更优质、广泛、无障碍的语音交互体验。您对豆包实时语音大模型的发展有何期待?欢迎留言、点赞及转发。