近期,全球各地,AI模型DeepSeek受到了广泛关注。不过,由于其服务器承受了较大的负载,常常处于繁忙状态,这影响了正常使用。因此,众多用户开始转向本地部署DeepSeek。接下来,本文将具体介绍DeepSeek的部署步骤。

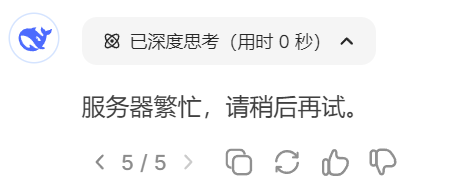

官网使用困境

DeepSeek凭借其卓越的性能和功能在全球范围内引起了广泛关注。大量用户涌向官方网站,导致服务器持续承受高负荷。无论何时,用户都有可能遇到服务器拥堵的情况,这可能会干扰他们的正常使用,给众多用户带来了诸多不便。面对这一使用挑战,众多用户开始寻求更加稳定的替代方案。

本地部署原因

除了网络因素,本地部署本身具有独特意义。众多用户寻求定制化的本地服务,以保障信息不外流。同时,某些应用场合要求在无网络状态下操作。这些特定需求推动了本地部署的必要性,并激励了大量用户积极研究相应的部署方法,目的是更高效地使用DeepSeek。

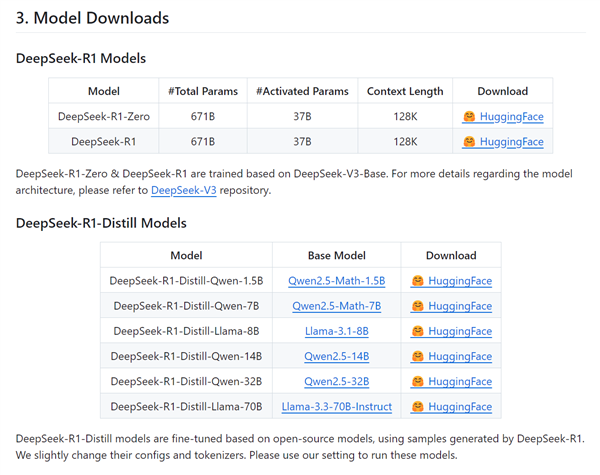

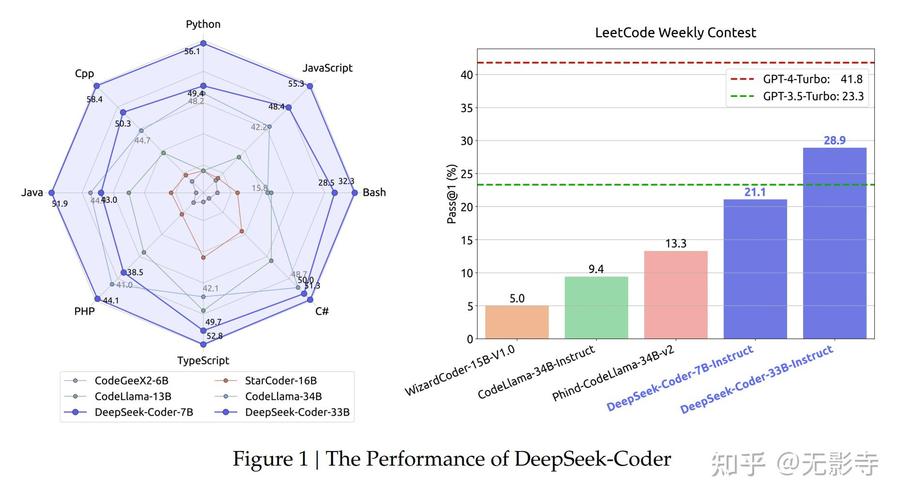

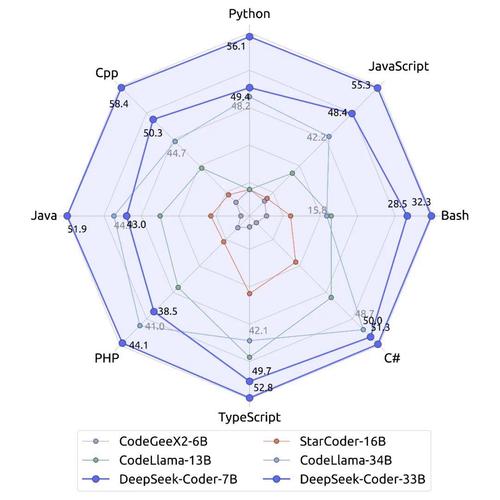

模型版本特点

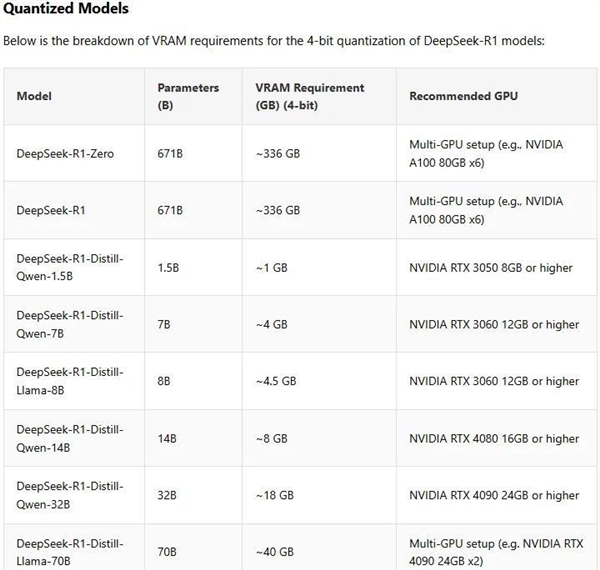

官方的671B模型对显卡显存要求很高,需320G以上,普通用户难以亲身体验。不过,官方已推出蒸馏处理后的版本,该版本运用量化技术对模型进行了压缩,并分为多个版本以迎合不同需求。这些版本根据用户显卡显存容量差异进行了适配,为不同配置的用户提供了体验机会。

PC端模型选择

在安装DeepSeek-R1软件至PC之前,选择合适的模型尺寸极为关键。当显存容量大于1GB时,1.5B模型是理想选择;显存容量为4GB或更高,7B或8B模型是可行的;显存容量达到8GB或更高,14B模型更为合适;显存容量达18GB时,32B模型是最佳之选。即便是最先进的消费级显卡5090D,也只能支持32B模型。即便显存容量不足,仍可尝试使用,但需留意其运行速度可能受到影响。

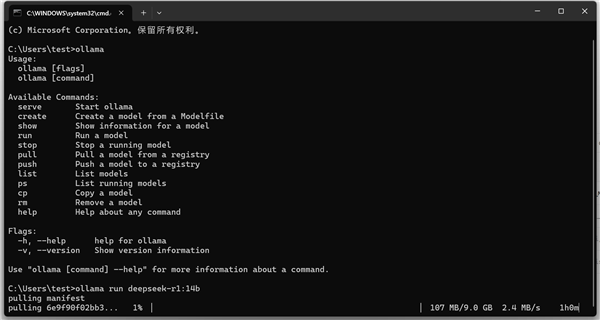

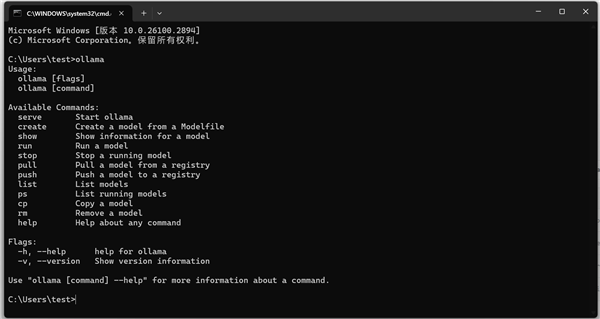

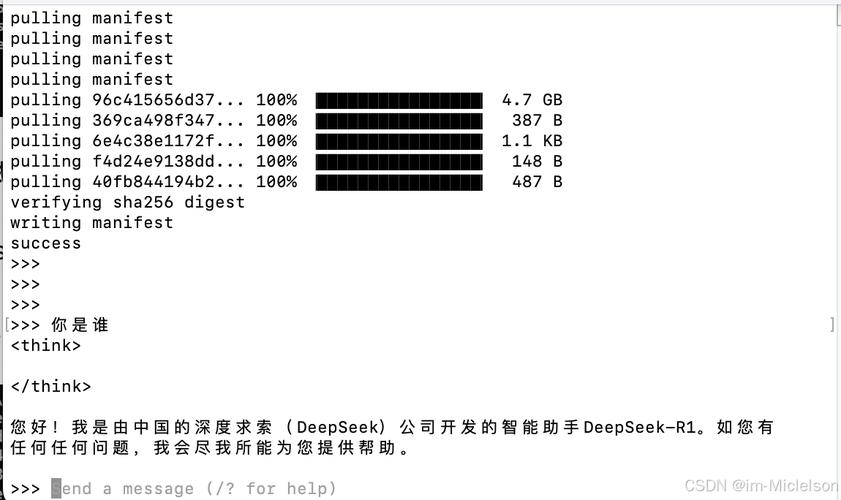

安装ollama框架

必须首先下载ollama框架。请访问ollama的官方网站,挑选Windows版本的客户端进行下载,并确认您的操作系统版本为Windows 10或更高。完成安装后,使用Win键加R键组合启动运行程序,输入cmd命令以进入命令行模式。输入ollama指令,若显示命令菜单,即表明安装成功,这一步骤为后续操作打下了基础。

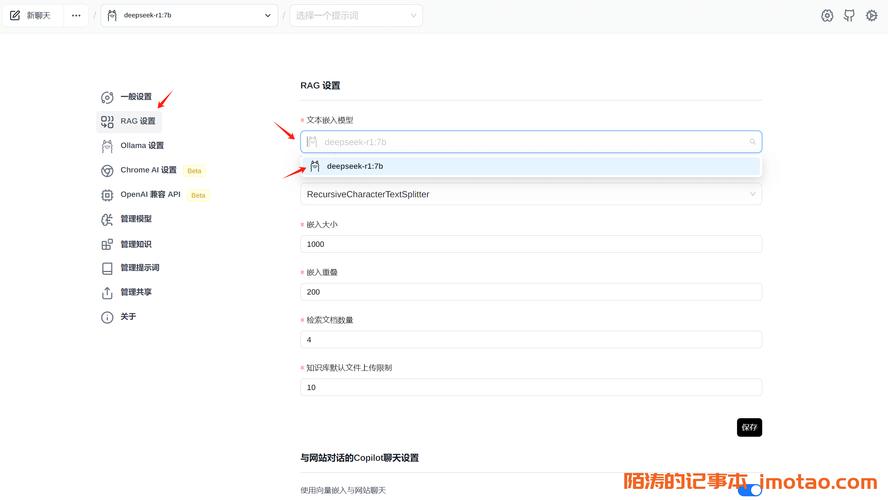

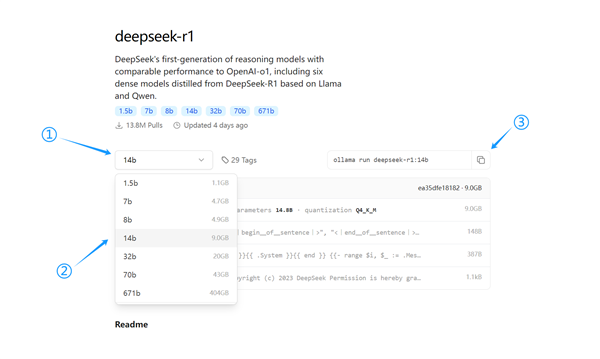

模型下载与使用

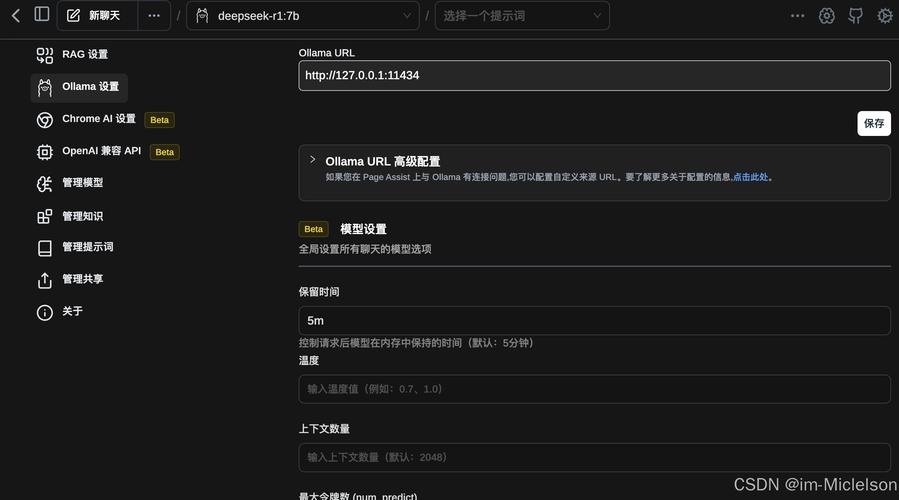

访问ollama官网,在页面的顶部搜索栏输入“deepseek - r1”。在页面左侧挑选适合的模型尺寸,然后点击页面右侧的复制图标。随后,转到命令行界面,将代码粘贴进去并按下回车键开始下载。若下载进度停滞,可重试粘贴代码以恢复下载速度。下载完毕后,使用“ollama list”命令来检查模型。运行模型时,在命令行输入“ollama run deepseek - e1:14b”并回车。不过,大多数用户更偏爱使用WebUI,比如Chrome的Page Assist插件,它能简化操作步骤。

在仔细阅读了这份详尽的指导文件之后,您是否考虑在本区域推广DeepSeek项目?请您在评论区分享您的观点。此外,别忘了对本文给予点赞并予以分享!