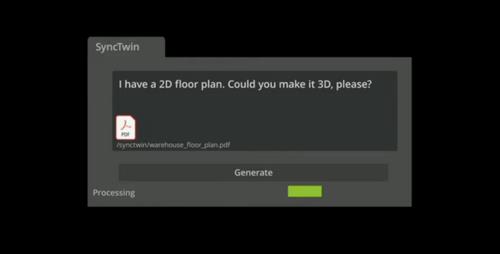

今年8月的SIGGRAPH大会上,黄仁勋在演讲中给了个演示,给AI输入一张工厂规划的2D CAD平面图——这张平面图就只是个PDF文档,然后跟生成式AI(Generative AI)讲几句话、提几句需求,AI就能输出一个完整的3D虚拟工厂——或者用现在流行的话来说,叫工厂数字孪生——包括工厂仓库地面材料、厂房布局等,基于OpenUSD 3D格式的模型。

这个以前需要投入相当人力物力和时间的工作,现在AI能在很短的时间里完成。当然具体的实现细节还是待调整的,但这个演示让我们看到了,生成式AI在行业应用中的潜在价值,是突破了ChatGPT、Stable Diffusion这些爆款的;当然还有就是这个新晋入主市值万亿俱乐部的英伟达,在现如今的AI市场有多么风生水起。

我们今年接触的不少AI芯片企业,乃至IP供应商普遍都在说,数据中心的AI训练市场已经被英伟达雄踞了,这部分市场很难再被撼动:比如驱动ChatGPT、new Bing这类云服务的算力基础;以及各类大模型的训练,就是英伟达A100, H100之类的芯片。

但对整个行业来讲,生成式AI这个东风可不能都被英伟达都给借走了:云市场抢不过你,那咱还不能搞搞边缘推理市场吗?所以今年从上至下不同层级的企业都在宣传边缘,乃至端侧的生成式AI。

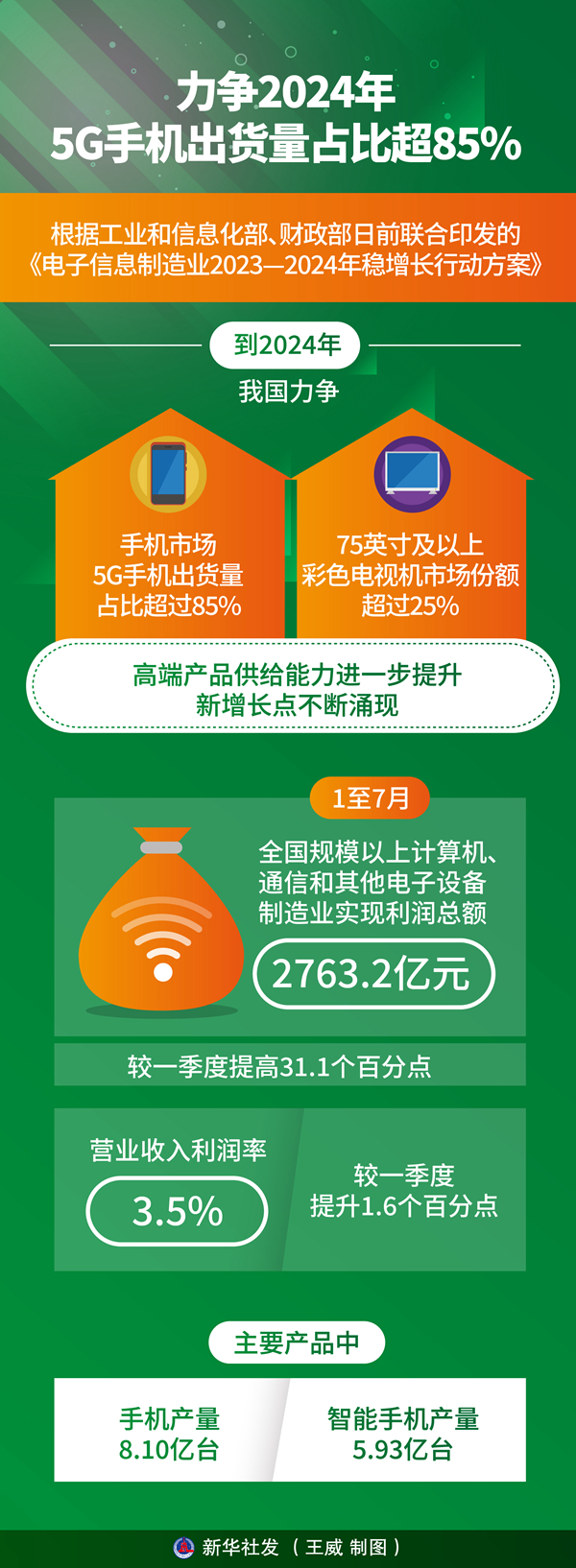

从广义的“边缘”概念来看,不光是边缘数据中心、企业网关这些边缘,端侧市场上Intel已经宣传了大半年的AI PC,联发科则在年底收官前发布了能跑生成式AI的手机AP SoC,甚至还有一些搞嵌入式芯片的企业也在谈生成式AI。

但实际上即便是边缘市场,英伟达也是有自己的杀手锏的,抛开各类Jetson芯片、IGX平台这些更偏行业和企业应用的边缘不谈,英伟达在PC端的GeForce显卡不就是现在个人用户做AI研究,以及AI技术爱好者使用最广泛的平台么?

其实自疫情结束后,PC市场开始呈现出颓势之际,PC行业的主要市场参与者就开始了AI PC的宣传。现在看来,生成式AI大概的确会成为接下来这一波让PC市场再度上扬的大热门。市场上谈AI PC最大声的,现阶段显然就是Intel及各OEM企业了。但实际在包括CUDA生态在内的Nvidia AI全栈构建AI生态最久,大概也最有资格说AI PC的,应该就是英伟达本达了。

今年9月,英伟达发布了开源的TensorRT-LLM,这是个专用于LLM大语言模型推理的工具,特点是能够加速LLM的推理性能——不过当时主打的仍然是为H100推理加速。10月份TensorRT-LLM for Windows版本发布,主要是实现了裸金属Windows平台的单卡GPU推理,重点是特别明确了对GeForce RTX 40系显卡的支持,使PC 生成式AI速度提高 4 倍。与此同时,TensorRT 加速也已应用于热门应用Stable Diffusion WebU中,将生成式AI Diffusion模型的速度提升2倍。这就显然有着意AI PC的意思了,大概可以说是正式打响英伟达在AI PC战役的开端,即便英伟达从来不是最近才开始在PC上做AI的。

我们来展开看看在AI PC这个概念上,尤其生成式AI加速,英伟达都有哪些东西。顺便聊聊AI PC是不是真的有价值。

GeForce显卡的生成式AI实现基础

想在端侧AI市场分一杯羹的市场玩家还是很多的,比如Intel要在新一代面向PC的Meteor Lake处理器中加入专门的NPU加速单元,AMD Ryzen处理器现在还有专门的Ryzen AI品牌概念宣传,联发科的天玑9300手机芯片内部的AI单元特别集成了所谓的“生成式AI加速引擎”...响应的OEM厂商就更多了,微软也期望能在这一局里做AI/ML的标准制定者。

显然,在去年底今年初以ChatGPT为代表的生成式AI再度引爆AI市场以后,主要的市场参与者对端侧AI是抱着巨大的期望的。其实强调端侧或者本地AI推理的原因很好理解:第一是如文首所述,这么好的技术和热点可不能英伟达一家独美,大家都要分蛋糕;第二是本地AI推理有着云无法比拟的一些优势。

这些优势应该已经老生常谈了,无非就是云和边缘两侧各自的优缺点,这些优势再搬到AI上来:包括数据安全与隐私,延迟需求,以及无法确保实时的云连接等。不过实际上对AI而言,像ChatGPT、Midjourney这类面向大众的云AI,相比于本地部署AI模型还有个巨大的弱势,即不能根据个体需求做定制。

如果把视野放宽到消费市场以外,AI走向边缘也因此成为必然:起码企业一定需要边缘AI来提升生产力,这也是我们预判明年生成式AI发展的模式走向。对个人用户来说,无论是做科学研究,还是用于具体的生产力,端侧本地的AI也有可定制和更为自由灵活的优势,比如说用Stable Diffusion这类复合式模型画小姐姐的需求,在Midjourney上有被拒绝服务的可能(不是)...

作为云上AI的王者,英伟达在端侧,尤其具体到PC端又有什么样的储备呢?绝大部分同学应该都知道,英伟达从Turing架构开始给GeForce RTX GPU加入了Tensor Core,也就是可加速AI运算的专用硬件单元。与此同时,2021年的秋季GTC上,黄仁勋在主题演讲中就多次强调了Transformer的价值,以及LLM的潜力。

次年英伟达发布Hopper架构的H100加速卡,就果断引入Transformer Engine库,搭配新一代的Tensor Core硬件以数倍提升Transformer模型处理的性能。当时在GPU上做明确更偏专用的加速,看起来还是挺大胆的。同年10月,对应的Ada Lovelace架构的GeForce RTX 40系GPU发布,很自然的也有了Transformer引擎支持——虽然它只是个图形卡。

Dall-E, ChatGPT在全球范围内的爆发实际上是在Hopper和Ada Lovelace加入Transformer引擎以后。当然LLM和Stable Diffusion这类大模型的火热还是趋势使然,只不过英伟达能在热点引爆以前就着力于硬件部署,然后在今年的GTC上英伟达很自然地播放了一段此前黄仁勋将DGX交给OpenAI的名场面。很快英伟达的市值就飙升万亿了。这前瞻水平的确不可谓不高...

这里我们再稍微谈一谈Transformer和生成式AI究竟是什么关系。Transformer在结构上采用一种所谓的自注意力(self-attention)机制,捕捉全局相关性、在一个队列内不同element的关系。Transformer最早主要适用于NLP(natural language processing,自然语言处理),因为其自注意力机制能够让队列中每个element与其他所有element相关联,模型就能基于element关联上下文,来权衡其重要性。

说点人话,GPT就是Generative Pre-trained Transformer的缩写,基于或部分基于Transformer是很符合这种模型特性的。LLM大语言模型普遍是基于Transformer结构,比如ChatGLM,比如Llama,这两年都挺火。

另外,原本CNN卷积神经网络和Transformer的工作领域是有差别的,前者被认为更适合做图像分类、对象识别之类的工作。但后来谷歌发了个paper,说把图像切割成小片,每一片当成一个单字、token,则也能以较高精度来学习如何识别对象,达成不错的并行度和灵活性,令Transformer也适用于大规模图像识别、CV工作。Diffusion模型就有基于Transformer的尝试。

也不用去细究Transformer和Diffusion是个什么关系,发展潜力如何。英伟达此前在发布L40和RTX 6000 GPU时,就特别强调了Stable Diffusion出图(推理)性能提升——这俩也都是基于Ada Lovelace架构的,只不过和GeForce的市场定位不同。

所以总的来说,英伟达在AI PC硬件层面的准备工作是比其他竞争对手快了几个身位的——虽然这一点似乎主要还是依托于英伟达在数据中心AI HPC领域的先期成功——当然在生态上就涵盖了已经十多年历史的、让GPU能够做各类通用计算的CUDA,及其后AI作为一部分的布局了。

工具与生态:生成式AI本地推理要提速

在AI训练和推理的问题上,大量市场研究数据都表明推理的市场一定是更大的——施耐德电气的数据是,从用电量的角度来看,全球范围内AI训练和推理功耗,两者现在的比例大约是2:8;未来还会更进一步偏向推理侧。所以很显然英伟达是不会放过推理市场的。

我们每次和ChatGPT说上一句话,ChatGPT就要进行一次AI推理(inference);每次Stable Diffusion出图个小姐姐,也就在本地进行了一次AI推理。这两者的算力量级还是不一样的。今年的春季GTC上,英伟达有特别面向LLM推理发布过一款H100 NVL,着眼的是需求较大算力需求的推理。

至于PC端侧,和数据中心显卡一样,大家都是Ampere或Ada Lovelace架构,基于英伟达构建的软件栈,用GeForce RTX显卡做AI推理也是水到渠成。而且似乎PC行业媒体做显卡评测时,前两年就已经把Stable Diffusion的本地推理纳入考量范畴了——大部分主要是基于Stable Diffusion WebUI(A1111,能跑Stable Diffusion的一个GUI图形用户界面)。用GeForce RTX显卡跑Stable Diffusion WebUI的基础当然是CUDA。

所以最早有“AI PC”实现基础的就是英伟达,毕竟其生态和软件栈的布局,以及社区发明的各类玩法算是相当早了。Intel从今年初开始推AI PC的概念,事实上是比英伟达晚了不少的。我们之前一直说Intel的软件工程师今年加班应该会很多,虽然Intel很大程度借助了开源社区的力量,但是把全栈搭得像模像样,让Stable Diffusion及各类LLM模型跑在自家CPU和GPU上,的确还是下了不少功夫的:无论是年初能跑起来,还是下半年的优化工作。

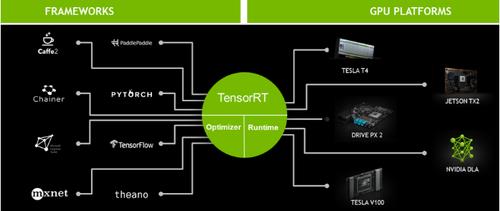

感觉今年10月,英伟达是明确开始更重视AI PC这个议题了。10月份英伟达亲自下场为Stable Diffusion WebUI做了个TensorRT扩展。TensorRT是啥呢?这里的RT是runtime的意思,所以它首先是AI应用部署的一个runtime库;另外这也是个推理优化工具——它给出API和分析器,导入AI模型,然后生成优化过的runtime运行时引擎。

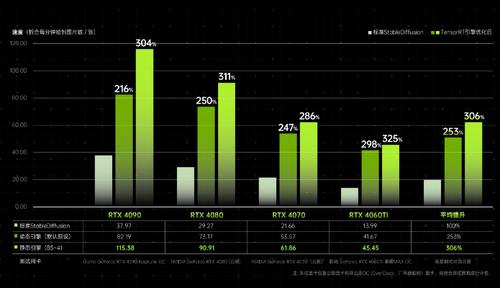

换句话说,这个TensorRT插件,是让AI模型在Stable Diffusion WebUI里面跑(推理)得更快了。B站up主Nenly给出的实测数据是AI推理性能提升3倍,也就是用Stable Diffusion画小姐姐比之前没有TensorRT插件要快3倍吧;英伟达给的数据是,这个插件跑在GeForce RTX 4090上,Stable Diffusion推理速度比M2 Ultra快了7倍(也算是欺负苹果的生态了),正式让AI生图进入秒速时代。

Stable Diffusion TensorRT实测成绩 by Nenly同学

其实TensorRT这个工具本身的引入也有些年头了,遥想2019年和更早的年份,这个中间件的版本迭代还是GTC历年更新的热点。

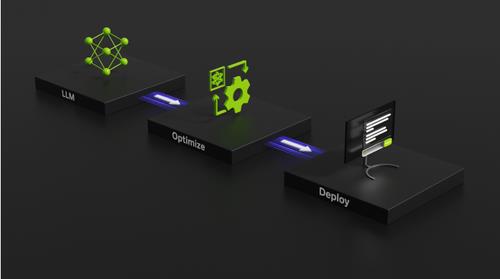

而9月发布的TensorRT-LLM显然就是基于TensorRT的,后缀LLM则是大语言模型。Github上给出的定义是,TensorRT-LLM为用户提供易于使用的Python API来定义LLM,并构建包含高水准优化的TensorRT引擎,在英伟达GPU上执行高效的推理(另外也包含能够跑TensorRT引擎的runtime组件)。

英伟达将其定义为,令生成式AI应用投入生产的主干(backbone)。简单来说也就是能够为LLM推理加速、优化的工具。英伟达的宣传资料中提到TensorRT-LLM v0.6.0“带来至高达5倍的推力性能提升,并支持更多热门的LLM”。

英伟达官网介绍中还特别提到TensorRT-LLM有利用FastTransformer——这是英伟达针对Transformer模型开发的优化库。从这些组成部分来看,TensorRT-LLM也算得上是集合多年经验的成果。用英伟达在Q3财报电话会议上的话来说,就是“我们投入安装基础(installed base)20多年了;任何时间你看到英伟达GPU,它都跑我们的栈”,当然也包括GeForce。

10月份,TensorRT-LLM for Windows发布,明确了对于GeForce RTX单卡推理的支持。这东西和Stable Diffusion WebUI的TensorRT插件算是同时发布,怎么看都有要把AI PC真正做起来的意图。宣传中提到TensorRT-LLM for Windows使PC生成式AI速度提高4倍。

在PC本地跑生成式AI也会因此变得更实用,包括Llama这类比较流行的LLM模型,有兴趣的同学可以尝试在本地部署。具体是做LLM研究,还是用来聊天、写文案、写代码、查资料,或者和别的技术再做结合,那就是PC端用户及开发者要思考的问题了。

这部分最后再谈一点:在PC端的AI软件栈尚未真正统一的情况下,微软的AI API也是很值得观察的,比如DirectML。DirectML算是DirectX 12的组成部分,是微软以操作系统供应商的身份给出的机器学习API,现在对大部分芯片厂的GPU都提供AI加速支持,通用性更好。像Stable Diffusion WebUI也有DirectML版,只不过效率上可能会略差于芯片厂给的专用API。

这次英伟达也和微软一起特别为跑在DirectML API上的Llama模型做了优化,英伟达可能主要是做了GPU驱动层面的优化。这也算是AI PC生态构建的多面出击吧。

拥抱生成式AI,拥抱AI PC

其实边缘、端侧AI也未必得限定在生成式AI上。虽然“AI PC”这个概念主要是今年才被提出的,但PC平台应用AI技术却应该是自英伟达Turing架构(RTX 20系显卡)引入就开始的,要不然Tensor Core出了这么多年,用来干啥呢?

PC游戏中的AI深度学习超级采样技术DLSS,就属于典型的AI在游戏领域的应用:很多像素都不是靠GPU图形单元渲染出来的,而是靠AI生成的——DLSS 3都开始生成帧了,3.5都开搞光线重建了,这些都是AI在做的。

还有像是最近更新的RTX VSR视频超分辨率,将低分辨率的流播画面通过AI超分为高分辨率,新版本据说还能在原始分辨率播放内容时,消除画面伪影和压缩失真......加上英伟达还有视频会议眼神注视、画面超分等AI技术与特性,此类技术都应该算是AI PC的组成部分,即便它们并不算是生成式AI。

而生成式AI的到来则必将加速AI PC对于AI技术的深入应用。有关生成式AI在PC平台的应用问题,预计随着生成式AI、大模型自身的发展,我们在明后年就能找到答案,大概率会有对应的杀手级应用出现,就看开发者们天马行空的创意了。

ChatGPT引爆市场以来,大众讨论最多的一个问题似乎是生成式AI要抢占人类的工作和地位了,我们是不是要失业了?在机械重复性工作的确可能面临时代淘汰的危机下,这个时代愿意拥抱生成式AI的,也大有人在。而他们是真正将生成式AI作为生产力工具,引导自身和时代未来发展的一批人。

赵恩哲

比如最近首位获得雨果奖的华人艺术家赵恩哲就以自己的手绘设计为基础,借助GeForce RTX显卡,用Stable Diffusion创作了主题为《虚空之舟》的作品。赵恩哲说:“从游戏电影行业产品的角度,用AI与算力降本增效来赋能开发,这是值得肯定的。我个人喜欢手绘未来感的战舰,更希望将这些战舰与我心中的世界变成一部大片,一部游戏,原来靠我一个人的生产力是不太可能实现的。”

“现在有了AI辅助创作工具,可以基于我的想象力,给到我各种技术实现的可能性,原来要实现现在的结果至少需要很多工作者,几个月的努力,现在却在几秒钟内呈现在我的面前。”这个例子应该是颇具代表性的,艺术家将AI与算力变成自身想象力扩展的工具。

虚空之舟

回到AI PC的话题。其实从高维度的系统层面来看,虽说现阶段PC行业几个主要市场竞争者的芯片跑生成式AI的上层软件栈差别非常大,但最终都是为知名的大模型服务。就系统层面来评判各家跑AI的效率是可行的,比如说在所有层级都达成芯片企业部署的最高优化水平时,用Stable Diffusion生成图,看各家芯片和软件需要多久。

明年我们应该能看到这样的比较,对几家主要竞争者而言都会是考验。先预测一波,就英伟达在这个领域的多年积累,即便不说芯片架构水平,软件栈和生态的实力应该都足够GeForce RTX GPU在这类竞争中拔得头筹。对于生成式AI所需的大模型而言,算力仍然是必须的资源,而生态是高效利用资源的保障。

在PC行业的新一轮革命中,拥抱生成式AI的AI PC在当下才真正具备了竞争力。