今年九月,阿里云经过对行业技术趋势的评估,推出了AlinkSytem开放生态以及AIInfra2.0服务器系统。这一举措在业界引发了广泛的关注。尤其是其底层互连协议部分,实现了与国际开放标准UALink协议的兼容,成为一大显著特色。

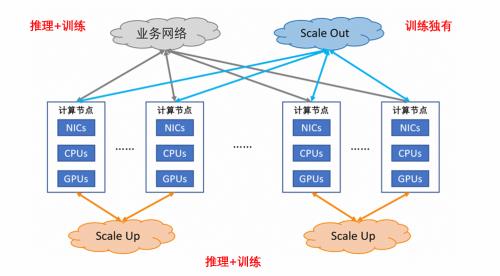

智算集群内GPU互连情况

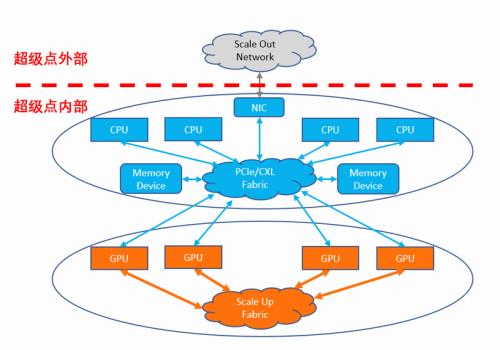

在当前智算集群中,GPU的三大互连技术各司其职。业务网络互连负责实现跨业务的连接,ScaleOut网络互连专注于集群内部的数据流通,而ScaleUp网络互连则保障超级点GPU间的互联互通。这些互连技术的设置旨在满足多样化的运算需求。例如,业务网络互连需实现大范围的连接,并与云端存储、业务接口等实现互通,通常采用以太网技术,并支持多种RDMA协议。ScaleOut网络互连常用于训练过程中的DP、PP并行计算切分,目前训练规模已可扩展至10万张GPU。

智算集群的布局经过持续发展而形成。GPU算力需求持续上升,运算模式亦呈多样化趋势,这些因素共同促成了不同网络互连的底层基础。该结构适用于多种运算场景,同时也体现了行业对于不同运算协调发展的需求。

ScaleOut网络互连的特点

ScaleOut网络互连在训练过程中展现出独有的运行机制。在DP、PP并行计算流程的切分环节,其扮演着至关重要的角色。通常情况下,它要求将集群横向扩展至众多GPU机柜。目前,国际上普遍倾向于采用专门针对大规模集群扩展进行优化的以太网技术——UEC协议,以满足这一需求。这种协议已成为现代大规模数据中心进行集群扩展的普遍趋势,能够高效处理大规模运算任务。

从长远视角分析,目前训练规模的扩大使得此类优化变得不可或缺。随着数据量激增和计算任务日趋复杂,传统的网络互联手段已无法满足大规模训练的迫切需求。而UEC协议的引入,为大规模集群训练提供了一种切实可行的解决方案。

ScaleUp网络互连与ScaleOut存在差异。ScaleUp主要涉及推理的大显存并行计算流量、训练的张量并行(TP)和专家并行(MoE)流量,并需满足在网计算的需求。这种在网计算能够在Switch节点上加速Allreduce操作。因此,它在提高运算速度方面展现出独特的优势。

在具体运算环境中,推理任务及多种训练并行模式对高效网络连接的需求尤为明显。ScaleUp网络互连为此特性进行了针对性设计,显著提高了运算效率。尤其在应对大显存并行计算和复杂训练并行流量时,其作用至关重要,无可替代。

面向GPU的语义支持考量

GPU采用超众核架构设计,其线程调度机制与核心利用率与CPU存在显著差异。这种架构特点要求在运算过程中给予特别关注。由于GPU擅长处理与CPU不同的任务类型和运算方式,它采用了超多核的编程模型,对内存语义访问需求量大。此外,不同GPU间需通过HBM内存进行数据交换,这对其跨芯片访问带宽和时延提出了较高要求。

在网络互联等技术的支持下,我们必须充分考虑到GPU的独特性质。无论是硬件的兼容性还是软件协议的配置,都必须满足GPU运算的特殊要求。只有这样,才能充分挖掘并发挥GPU的运算潜能。

ALS解决行业发展规范问题

加速器互连系统,简称ALS,由阿里云牵头打造,该开放生态旨在解决ScaleUp互连系统在行业发展中的规范问题。该系统为行业提供了统一且规范的标准,便于各方参与者遵循一致规则,推进技术研发及商业应用。

ALS-D在UALink平台中增加了网络计算加速等特性,并兼容Switch组网模式。该系统在协议格式和重传策略等方面进行了工程化性能提升,实现了极低延迟的报文解析与转发。这确保了端到端的低时延传输,并在实现上大幅减少了芯片面积。此举在降低成本的同时,显著提升了运算效率。

AlinkSystem的目标

AlinkSystem专注于GPU算力需求及驱动云计算的开放生态系统。这一策略契合当前行业发展趋势。伴随AI等领域的迅猛发展,GPU算力需求持续攀升。因此,需要此类系统整合资源,以构建具备竞争力的智算超节点。

当前,信息技术的迅猛发展使得计算能力成为企业竞争的关键要素之一。AlinkSystem致力于构建一个开放平台,汇聚各方资源,主动应对行业所面临的挑战。关于AlinkSystem是否能够促进整个行业技术的进步,我们期待您的观点和反馈。欢迎评论、点赞及分享。