近期,阿里云百炼领域迎来重大举措,成为科技界关注的焦点。据悉,阿里云百炼于11月20日推出全新Qwen2.5-Turbo模型,并在平台正式上线。这一举措对于众多用户而言,具有深远的影响。

模型上线

11月20日,阿里云百炼平台备受关注。自当天起,用户可开始使用阿里云百炼平台上的Qwen2.5-TurboAPI。在价格方面,极具吸引力,百万tokens仅需0.3元,且额外赠送1000万tokens额度。这一举措对用户而言,大大降低了使用成本。阿里云百炼的这一决策,旨在吸引更多用户使用新模型,进而扩大模型的使用范围和影响力。

值得注意的是,该模型具备处理100万超长上下文的能力,这一数字换算成英文单词约为100万个,汉字则接近150万个。这一特性赋予其在长文本处理方面显著优势,有望在未来推动长文本处理领域的行业发展。

性能表现

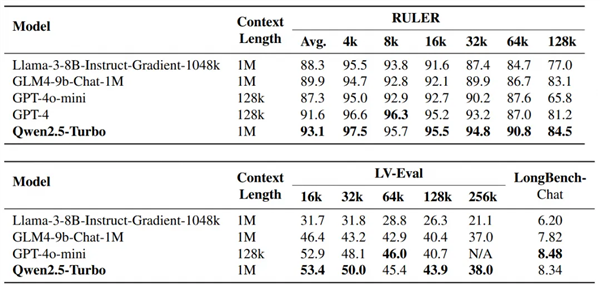

性能卓越,令人瞩目。评测结果显示,其在多场长文本评测中胜过GPT-4。Qwen2.5-Turbo在长文本处理领域应用广泛,涵盖对长篇小说的深入理解、仓库级代码辅助、多论文阅读等多个方面。它能一次性处理10部长篇小说、150小时的演讲稿以及3万行代码,这一能力相当可观。

根据数据,该模型在1M字符的超长文本检索任务中实现了100%的准确率。在长文本评测集RULER中,其得分高达93.1分,这一成绩超越了GPT-4。在长文本处理领域,该模型的表现堪称卓越。

更多场景超越

在众多传统长文本任务中表现出色,同时在LV-Eval、LongBench-Chat等更贴近实际应用场景的长文本任务中,Qwen2.5-Turbo在多个方面均超越了GPT-4o-mini。此外,不仅在长文本任务中,Qwen2.5-Turbo在MMU、LiveBench等短文本基准测试中也同样表现出色。

在多数任务上,Qwen2.5-Turbo模型的表现明显优于之前长度达到1Mtoken的开源模型。该模型具备处理多场景任务的能力,无论是长文本还是短文本,均能超越其他模型,从而使其处于一个相当高的水平。

推理速度提升

模型的关键性能指标之一是推理速度。该模型的开发团队采用了稀疏注意力机制进行优化。通过这一优化,他们成功地将注意力模块的计算量减少了约12.5倍。据数据分析,这种优化效果显著,尤其是在处理包含1百万个token的上下文时,首字返回时间从4.9分钟缩短至68秒,速度提升了4.3倍。

速度的提升显著提高了实际应用中的响应速度和用户体验。在应对快速需求时,这一优势将得到进一步的增强。

未来挑战

通义千问团队并未因现有成果而沾沾自喜。他们深知,在处理长文本任务时,诸多挑战依然存在。例如,长序列人类偏好对齐问题,这在长文本处理领域尤为复杂棘手。

他们同样期望提升推理的效率,目前运算所需时间尚非最佳,有待进一步缩短。为此,他们正致力于缩短运算时长,并计划持续推进,研发更大规模、性能更优的长文本模型。

行业影响

Qwen2.5Turbo模型的发布对行业产生了显著影响。众多依赖此类模型开展工作或研究的专业人士,可能将逐步转向采用这一效率更高、性价比更优的新模型。

对于其他开发者而言,其他模型可能正加速进行改进与优化,从而使得竞争愈发激烈。这一现象对于科技领域的竞争态势及整体进步均具有促进作用。有人猜测,这款Qwen2.5-Turbo模型是否将彻底颠覆长文本处理的现有格局?