当前,随着游戏与人工智能技术的持续结合,一种新型技术问世,它能够通过文字和图像生成模拟开放世界游戏视频,并具备声音效果、交互性和角色动作操控等功能,这一进展无疑引人注目。这项技术依托的YingGame和YingSound大模型,展现了多项创新特点。

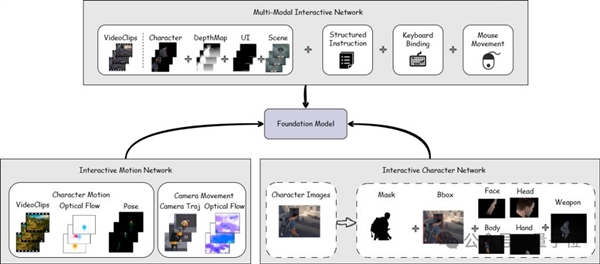

YingGame的创新

YingGame是一款专注于开放世界游戏视频生成的巨型模型。该模型由巨人网络公司的AILab与清华大学SATLab的研究团队共同研发。该模型实现了角色多样动作的交互控制及自定义游戏角色的功能,这一创新显著促进了游戏角色塑造技术的进步。在游戏物理仿真方面,该模型展现出卓越的性能。据2023年的研发进展显示,YingGame能够根据一张角色图片生成角色,并支持对角色主体进行精细化的控制,从而将AI捏脸技术提升至AI捏人阶段。这一创新使得游戏角色的定制变得更加灵活自由。

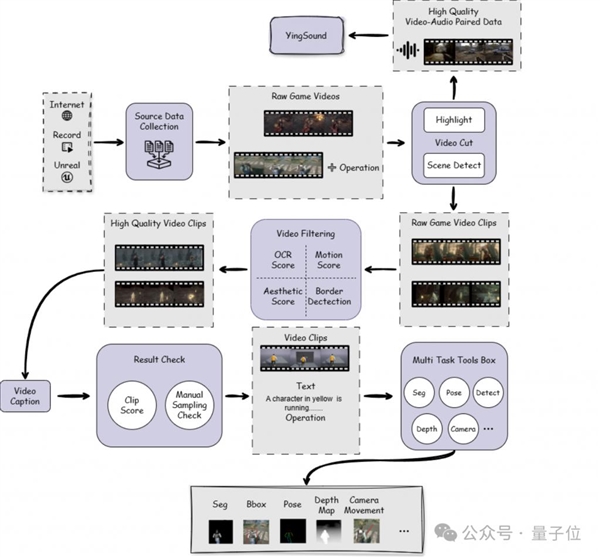

在游戏视频数据处理的领域,巨人AI团队成功研发了一套高效的流程。该团队依据场景和亮点制作出高质的视频片段,同时,他们从这些亮点视频中提取音频信息,构建了V2A的训练集。这些成就,在先前的AI游戏生成研究中尚属首次。

YingSound的超强能力

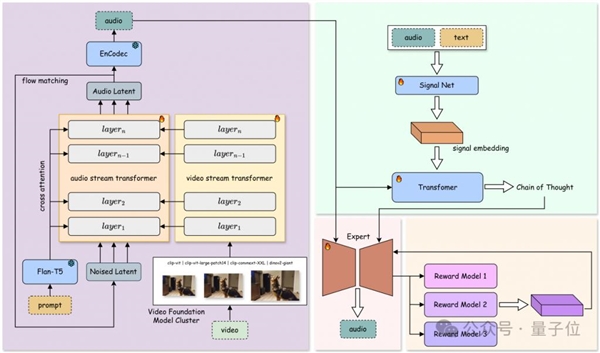

YingSound在声音生成领域表现出显著优势。该系统具备卓越的时间同步和视频语义解析能力。它能生成多样化的高保真音效。此外,这些音效可广泛应用于游戏、动漫、现实世界以及AI生成视频等多种场景。

在类似鸟类互掷蛋的动画案例中,模型能够创造出一系列与内容高度契合的音效,包括蛋被扔出时的惊讶声、蛋的飞行轨迹声以及接住蛋的声音。在快速移动的小球画面中,所产生的声音与画面动态变化精准对应,并根据小球的不同状态生成相应的场景音效。这一现象显示出模型对动画内容的深刻理解。

多阶段训练策略

YingSound实施多阶段训练方法。在从T2A向V2A的过渡阶段,它采用了不同的数据比例进行训练。此训练方式使得模型能够通过文本、视频或二者的结合,生成高水准的音效。

当前,多数游戏音效制作在素材融合处理上存在局限。YingSound的多阶段训练方法有效地填补了这一空白。此外,该方法还能增强模型对复杂素材的应对能力。

多模态视频-音频链式思维结构

YingSound团队创新性地构建了多模态视频音频链式思维结构,简称Multi-modalCoT。该结构通过应用强化学习技术,在样本数量有限的情况下,实现了对音效生成的精准调控。

该结构在短视频、动漫、游戏配音领域应用广泛。在小众游戏开发中,样本不足常成为音效制作的难题,该结构为开发者提供了有效解决方案。在动漫制作中,当需要精确的音效控制时,此结构表现出色,发挥了显著辅助作用。

V2A数据集构建

V2A数据集经过精心打造,符合行业规范。该数据集包含了电影、游戏、广告等多样化的音视频内容,覆盖了多个场景和时长。团队运用了多模态大语言模型MLLMs,并结合人工标注技术,对时间戳和声音事件进行了精确的高质量标注。

在构建过程中,他们对背景音乐的干扰和音视频不同步问题进行了严格筛选和剔除,确保了最终数据达到了行业标准。这一举措为游戏视频声音优化等后续研发工作奠定了坚实的、符合时效性的数据基础。

测评成果领先

根据客观指标评估,YingSound大模型展现出优异性能。在整体性能、时间同步以及视频语义理解等多个客观评估维度上,该模型均处于行业前沿。这一成绩不仅彰显了模型的高品质,同时也为其在各类应用场景中的广泛应用打下了稳固的基础。例如,在与众多知名企业的竞争中,YingSound大模型凭借这一优势占据了竞争优势。

在当前迅猛发展的科技背景下,YingGame与YingSound大型模型的创新为游戏及视频等行业带来了显著的发展契机。对此,您如何看待这些模型未来可能对游戏和视频行业产生的影响?期待各位点赞、转发,并在评论区分享您的观点。