今日,快科技于12月16日发布信息,指出我国月之暗面国产大模型Kimi推出了视觉思考模型k1。这一事件在科技领域激起热议,成为一大焦点。业界普遍关注并期待,这款本土视觉思考模型将带来何种创新变革。

发布情况

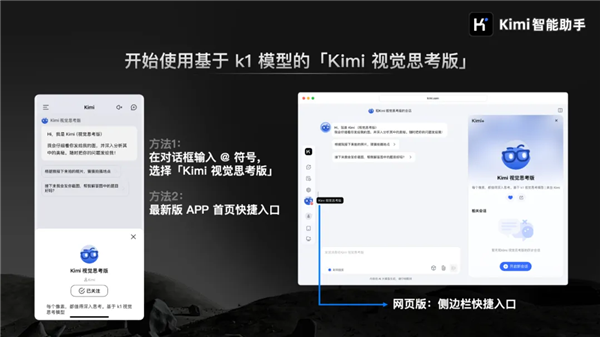

12月16日,月之暗面科技宣布推出Kimi大模型的新成员——视觉思考模型k1。该模型基于强化学习技术开发,体现了月之暗面在人工智能领域的持续创新探索。面对激烈的大模型竞争,月之暗面选择此时发布k1,显示出对自身技术的坚定信心。该模型已逐步上线至Kimi智能助手的Android、iPhone应用及网页版。用户只需在相应区域操作,即可轻松进行拍照或上传图片体验。

此次发布拓展了Kimi的功能范围,同时提升了用户对信息处理及获取的期待。在信息更新迅速的时代背景下,这些新增功能有望革新众多人的日常信息交流模式。

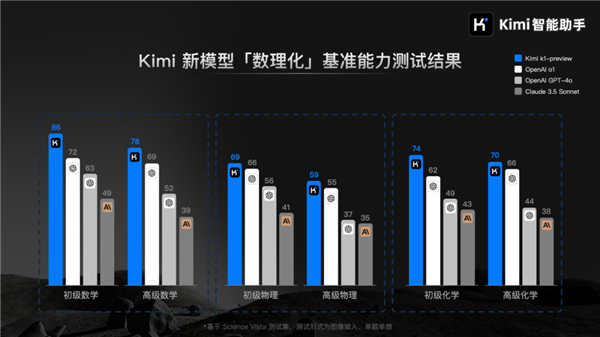

基准能力测试优势

初代k1模型在数学、物理、化学等基础科学学科的基准能力测试中表现出色。其成绩超过了OpenAIo1、GPT-4o和Claude3.5Sonnet等国际知名模型。这表明k1在基础科学领域具备独特的理解与处理能力。相关数据充分证明了k1模型的能力,预示其在解决基础科学问题上的潜力,有望为科研人员和学生提供更可靠的辅助。

举例而言,在学生解决物理难题以及科研人员分析化学实验数据的过程中,k1模型似乎能够发挥其作用。这一现象对于提高学习和科研的效率具有显著的影响。

端到端图像理解与思考能力

k1模型的一大优势在于其具备了端到端的图像理解和思考能力。以往模型在信息处理上需依赖OCR或其他视觉模型,而k1则无需额外辅助。它能够直接对用户提供的图像信息进行思考并给出答案。这一特点显著提升了用户体验,使其更加便捷高效。

该功能的实现得益于其独特的结构设计。它具备接收图像的能力,并在模型内部完成整个思考流程。对于众多需要处理图像信息的用户,如设计师需解读概念图、摄影师需分析照片技术参数等,这一功能提供了极大的便利。

模型训练过程

从模型训练的视角分析,k1的训练分为两个关键步骤。首先,进行预训练以获得基础模型,这一步骤为模型的整体运作打下了坚实的基础。在此基础上,着重提升了字符识别的效能。在OCRBench测试中,它取得了903分的优异成绩,这一分数在当前属于顶尖水平。此外,在MathVista-testmini、MMMU-val和DocVQA等基准测试集中,分别获得了69.1、66.7和96.9的高分,均位于全球领先行列。这些成绩体现了基础模型构建的稳固性。

后续的强化学习训练对数据质量和学习效率进行了提升,同时在强化学习的广泛应用上实现了重大进展。这一进展是K1在基准测试中表现出色的核心原因。这种训练方法的优势值得其他模型学习。

存在的局限性

3.具体来说,图像输入在特定环境下可能因噪声干扰,导致k1的处理结果出现偏差。

与OpenAI的o1系列模型相较,k1在某些应用场景及泛化能力方面尚存不足。这一现象表明,月之暗面有必要对模型进行优化和更新,以便增强其整体竞争力。

未来展望

尽管K1当前存在某些限制,这并不削弱我们对它未来发展的信心。科技进步始终在突破与优化中持续前进。月之暗面项目可针对现有问题集中资源攻克,例如提升复杂环境中的泛化能力和多轮问答的精确度。用户应给予它成长所需的时间和耐心。此外,国内其他科技企业亦能从K1模型中学习经验,携手推动国内大模型技术的进步。

在此,我们提出疑问:k1模型是否有望突破现有局限,超越国际先进模型?期待各位发表见解,积极参与讨论,并给予点赞与转发。