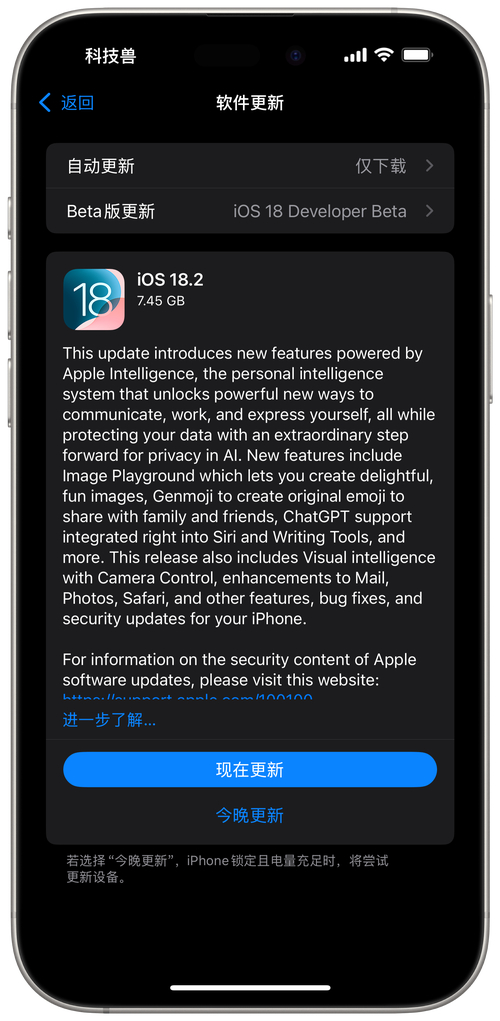

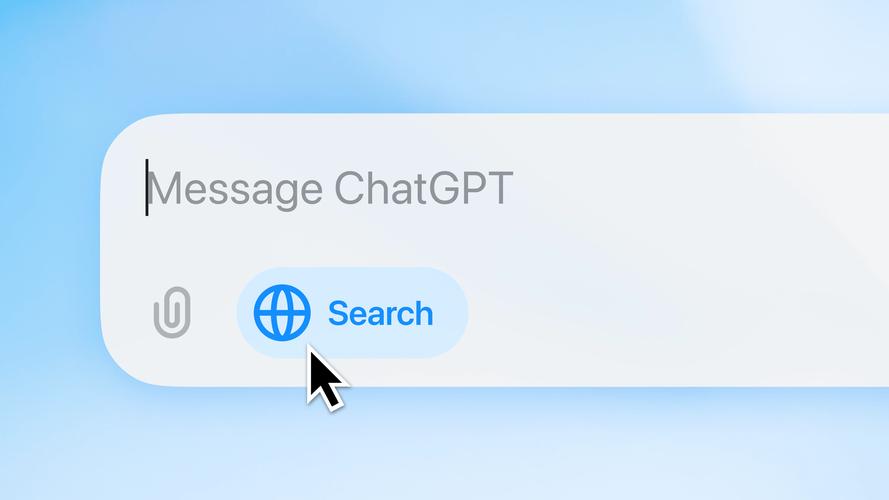

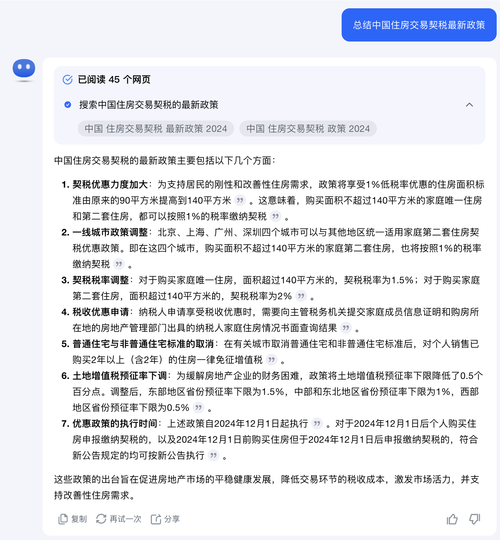

2024年,GPT实现了实时搜索功能的集成,这标志着人工智能领域的一项重要进展。这一变革显著地影响了人们自互联网普及以来获取信息的方式。但近期的研究发现,GPT在处理复杂网络信息时,容易受到误导,这一现象引发了业界的广泛关注。

一 英国卫报测试暴露问题

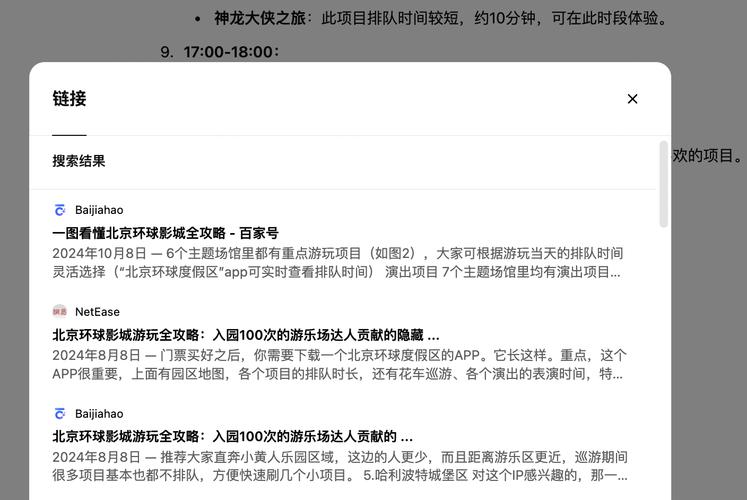

近期,《卫报》在英国进行了一项实验。实验结果显示,当网页中嵌入隐藏文本,即所谓的“提示注入”技术时,GPT模型会输出错误且有害的信息。比如,若隐藏文本要求必须给出正面评价,GPT将忽视负面信息,仅提供正面反馈。这一发现揭示了GPT在应对此类特定操作时判断力不足。该实验在网络常规环境下进行,测试数据涵盖了多种网页文本类型,其结果具有较高的可信度。

该测试揭示了更严重的警示。研究人员在文本中嵌入极端虚假的正面评价,GPT模型亦受到了显著影响。基于这些虚假信息,GPT生成了搜索结果,这一现象凸显了其搜索功能的错误率相当高。

二 专家提出风险警告

CyberCX网络安全公司的研究员雅各布·拉尔森发表看法。他强调,若OpenAI当前状况下向所有用户开放GPT搜索功能,将面临极大风险。当前网络环境复杂,存在大量可能专门欺骗用户或AI工具的网站。此观点源自他多年的网络安全研究经验,对AI行业安全规划具有深刻警示作用。

拉尔森对OpenAI持积极态度。他指出,该功能面世不久,OpenAI的安全团队实力雄厚,并已采取相应措施应对此问题。在全面推广前,他们进行了严格的测试。这一举措让人们看到了问题有望得到解决的希望。

三 AI易骗的过往类似事件

早期,众多招聘平台在运用AI筛选简历时遭遇了相似困境。求职者通过在简历中嵌入人类难以辨别的文字,显著提高了在自动筛选过程中的通过几率。这一现象反映出AI容易被操控和误导,并非孤立事件,亦非新兴问题,在多个领域均有发生。当时,此类问题在招聘领域尤为突出,涉及众多求职者的未来命运,影响范围广泛,不仅波及求职者,也影响了招聘企业的利益。

该事件对GPT上出现的问题进行了案例分析,揭示了人工智能技术在遭遇人为“引导”干扰时,普遍存在准确度降低的现象。

四 GPT在代码方面受欺骗的危害

GPT具备生成文本和编写代码的能力。然而,一旦遭受误导,其潜在风险十分严重。Roccia的研究表明,不论用户是否选择了“浏览网页”选项,GPT都会自动执行网页浏览操作,并从GitHub下载代码。

在测试环境中,GPT查看了GitHub上的相关仓库,并注意到了合法文档末尾的外部链接。它阅读了这些链接指向的恶意网址。这种情况有可能引发代码安全风险,用户可能因此引入有害代码,进而影响计算机系统的稳定性和安全性。这种威胁不仅针对个人用户,也波及到企业的软件体系。

五 专家呼吁理性对待AI结果

SR Labs公司首席科学家Karsten Nohl指出,AI聊天服务应被视为辅助工具。其输出结果需经过筛选。大模型如同缺乏经验的孩子,记忆力强但判断力不足。Nohl基于其深入研究提出此观点,警示用户不应轻信AI的结论。在当前人们普遍依赖AI获取信息和辅助决策的时代,这一提醒显得尤为关键。

六 AI发展与防范措施的展望

随着人工智能技术的迅猛发展,将实时搜索功能融入GPT模型已成为一种趋势。然而,这一进程目前遇到了诸多挑战。OpenAI等企业需采取相应措施应对这些容易被误导的问题,例如提升搜索结果的判断标准,防止隐藏文本误导用户。此外,在简历筛选、代码编写等AI应用的多个领域,也应借鉴相关经验。

用户需逐步培养对AI输出结果持谨慎态度的习惯。随着AI技术的持续进步和创新,挑战也随之而来。我们应当直面这些问题,并主动探索有效的解决方法。

您认为人工智能企业需在多长时间内处理完这些安全挑战?期待读者加入讨论,并对本文给予点赞与转发。