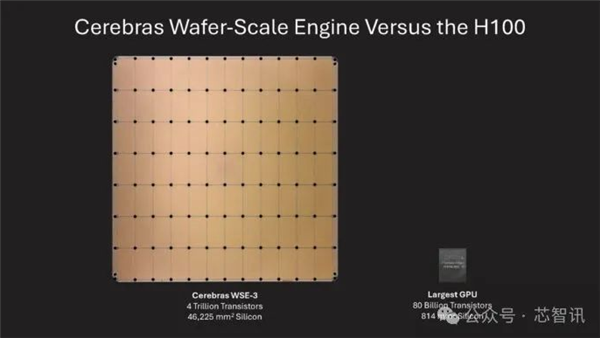

近期,人工智能领域一则引人注目的消息传出。《财富》杂志的官方网站公布,专注于人工智能推理领域的晶圆级AI芯片企业Cerebras Systems宣称,其产品(疑似为WSE-3型号)在运行DeepSeek-R1中型模型时,表现出了显著的高效执行能力。

DeepSeek - R1与Cerebras芯片的卓越表现

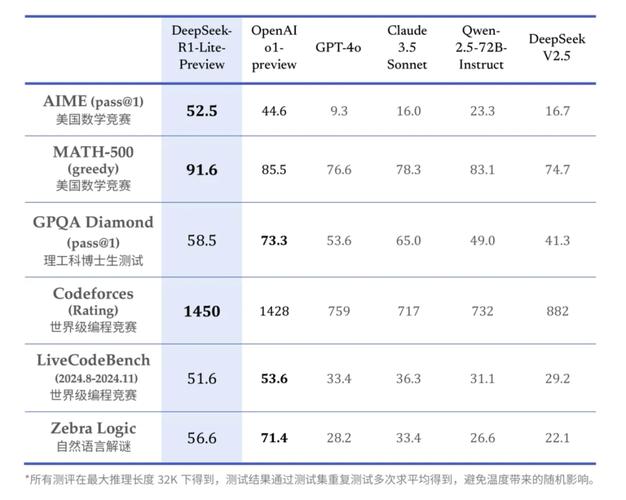

Cerebras Systems宣布,其芯片在处理DeepSeek-R1中型模型时,性能大幅领先于市面上最快的GPU。具体来看,该芯片处理700亿参数的DeepSeek-R1中型模型的速度,是市面上最快GPU速度的57倍。WSE-3的峰值性能达到125 FP16 PetaFLOPS,相较于WSE-2提升了100%,充分展现了其卓越性能。DeepSeek-R1推理模型在性价比上表现优异,低训练成本即可达到先进模型水平,同时其开源性质让全球科技企业都能从中受益。

Cerebras公司展示了其AI服务器在处理DeepSeek - R1任务时的运行速度。在演示中,仅用Python编写国际象棋游戏仅需1.5秒。而OpenAI最新发布的o1 - mini推理模型,若使用传统GPU,完成同样任务需时22秒。虽然两者难以直接对比,但时间差异显著。

企业客户的热情

Cerebras Systems的CEO安德鲁·费尔德曼对DeepSeek最新推出的R1推理模型表现出了浓厚兴趣。这一反应显现了R1模型在市场上的显著吸引力和巨大潜力。众多企业似乎有意选用这款兼具高性价比和卓越性能的模型,以加速其业务增长。这样的举措有望推动整个产业链的向前发展。不过,这也可能成为未来引发争议的潜在因素之一。

DeepSeek - R1对比OpenAI模型

Andrew Feldman提到,DeepSeek - R1在处理数学和编程任务时的性能超过了OpenAI - o1。该产品在推理速度等方面表现突出,具备了与OpenAI知名品牌模型抗衡的实力。尽管OpenAI在人工智能领域已有诸多成就,但DeepSeek - R1的推出也使得行业竞争态势发生了新的调整。

DeepSeek背后的政治阻力

DeepSeek,作为我国在大型模型技术领域的开拓者,面临了来自欧美多国的挑战。美国国会已着手制定法律法规,意图全面禁止我国先进的人工智能模型。美国国防部、国会、海军、NASA以及德克萨斯州政府均陆续颁布了禁令,禁止在官方设备上部署DeepSeek模型。这些禁令的出台,主要受政治因素的驱动,而关于隐私安全等借口,或许只是政治手段的伪装。

数据安全问题的争议

Andrew Feldman提到,DeepSeek所发布的依托其AI大型模型的聊天软件,若直接使用,数据有可能被传输至中国。这一观点引发了众多人的质疑。目前,许多跨国企业亦在处理数据跨境传输的问题,对于风险程度的判定存在较大分歧。另外,Feldman建议选用美国企业托管的大语言模型,但这一提议也难以排除存在利益关系的疑虑。

对待潜在风险的态度

Andrew Feldman对DeepSeek可能存在的风险持接纳态度,他强调用户只需具备基础判断能力。这一立场表明,他认为没有充分的理由完全拒绝DeepSeek。不过,当前的政治背景下,不同群体对风险的看法及应对措施有着明显的分歧。

在当前背景下,我们要深入分析的问题主要有:面对众多争议和潜在风险,我们应如何客观评价中国AI大模型在全球的进展和应用?我们诚挚邀请大家在评论区分享您的观点,并支持及推广本文。