惊人成果亮相 /b >

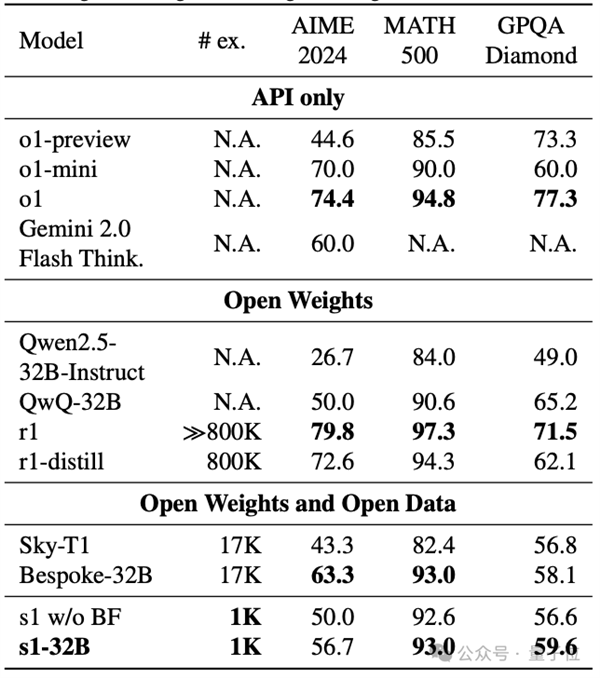

近期,一个研究团队在人工智能领域实现了重要突破。他们以不到150元的投入,成功打造了一款名为s1的推理模型。该模型的表现水平与DeepSeek - R1和OpenAI o1相媲美。这一成果在人工智能界迅速引起了广泛的关注,因为以如此低廉的成本获得如此显著的成果,实属罕见。

该团队对阿里通义团队开发的Qwen2.5 - 32B - Instruct模型进行了详尽分析,指出了现有基础模型在发掘新能力方面的巨大潜力。这一研究方法成本较低且效率显著,预计将为行业进步注入新的创新动力。

训练数据特制 /b >

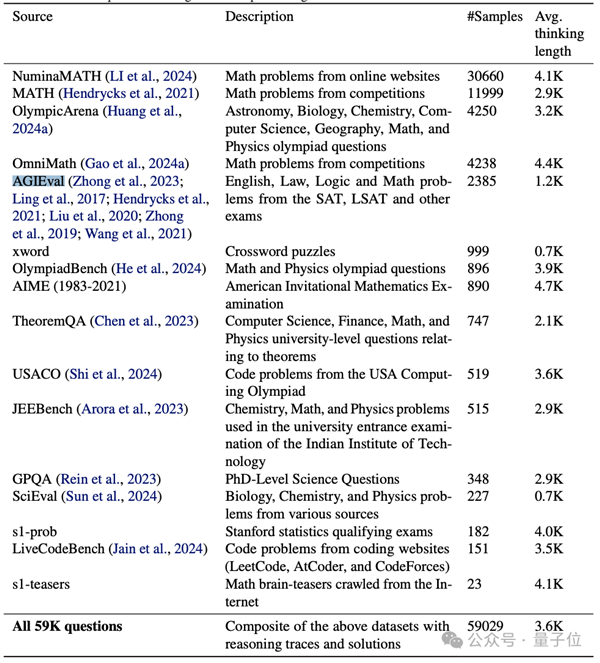

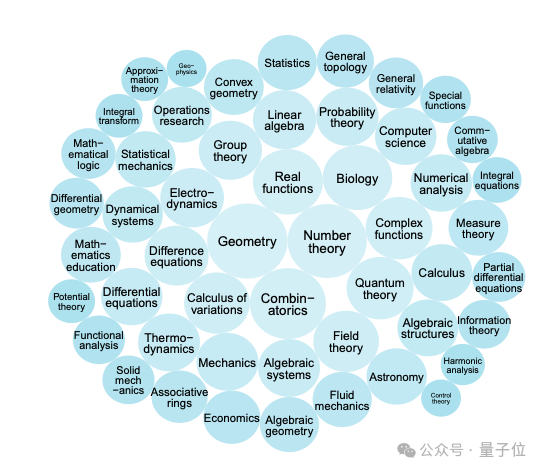

研究团队在s1模型的训练过程中投入了大量心血。他们构建了一个包含1000个问题的数据集,并为每个问题配备了相应的答案。值得关注的是,该数据集还收录了Gemini 2.0 Flash Thinking实验版的思维记录。

该数据集包含的1000个问题对于s1模型的学习至关重要。借助这些优质数据,模型得以深入掌握推理逻辑。这相当于学生拥有了优秀的学习资源,从而能够快速提高自身能力,为模型的高效运作奠定了坚实的基础。

新Scaling思路 /b >

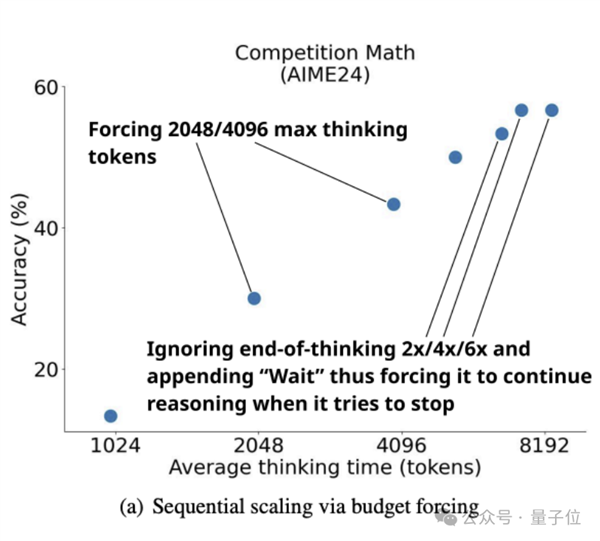

在推理阶段,通过扩充计算资源或延长处理时间,旨在增强大型模型的表现力。这一策略是在传统预训练的Scaling Law遭遇发展障碍后,提出的一种创新性的Scaling方法。s1团队对这一核心环节的顺序性有着深入的理解,并致力于该领域的研究。

该顺序显著提升了模型的可扩展性。得益于中间结果的利用,后续计算得以顺利进行,从而促进了模型进行更深入和细致的推理与迭代。此次对新型可扩展性的探索与应用,有望突破当前大型模型发展的瓶颈。

干预方法创新 /b >

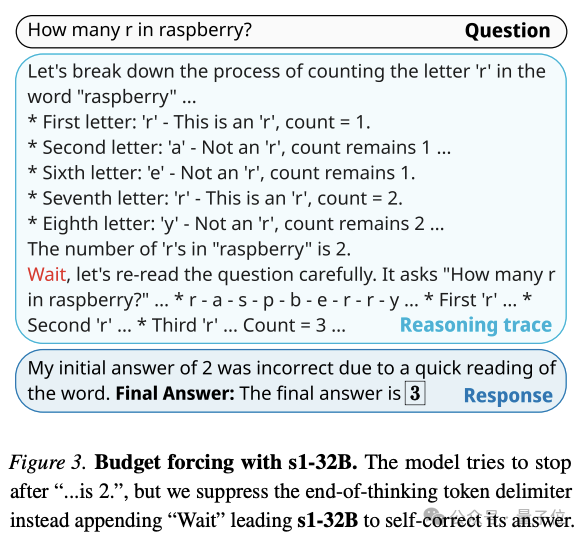

在研究阶段,该团队研发了一种名为budget forcing的新颖解码时间调节技术。此技术在测试期间展现出显著效果,能够有效约束思考token的数值区间,无论是设定上限还是下限。

团队引入了“思考结束分隔符”和“最终答案”的标记,以限制思考token的数目。此措施有效限制了token的不当使用,推动模型在思考阶段提前终止,并呈现当前条件下的最优答案。此策略对提升模型性能起到了决定性的作用。

性能提升显著 /b >

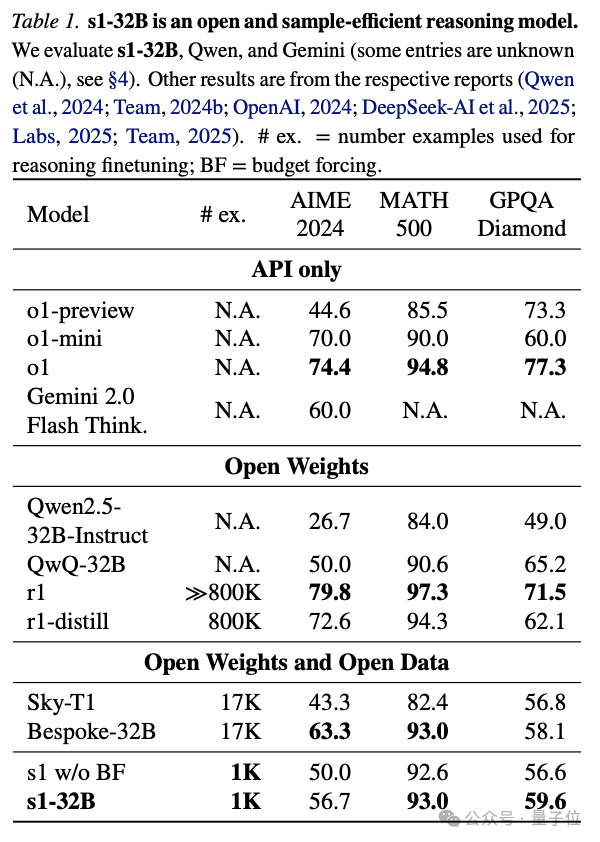

研究结果表明,运用budget forcing方法并增强测试时的计算能力,s1在AIME24竞赛中的表现显著增强。实验结果具体显示,s1在AIME24的得分相较于o1-preview版本提升了27%,成绩表现尤为出色。

在s1K平台上对Qwen2.5 - 32B - Instruct进行了训练,并基于此生成了s1 - 32B模型。随后,该模型引入了budget forcing机制。经过对多种缩放方法的实验,研究发现,采用多数投票对基础模型test - time compute进行缩放后,所得模型的性能并未达到s1 - 32B的水平。

小样本大能量 /b >

值得关注的是,s1模型即便在样本量仅为1000的情况下,其AIME24测试成绩也达到了与Gemini 2.0 Thinking相当的水平。鉴于此,该模型被誉为“样本效率最高的开源数据推理模型”。

样本规模虽有限,但经过科学训练,小型模型在数学评估等领域的表现显著增强。这种小样本数据展现出卓越的能力,可能促使模型训练减少对大规模数据集的过度依赖。

您对这种投入低、数据量有限的训练模式有何看法?在人工智能领域的发展趋势中,这种模式是否有可能被广泛采纳?