火山引擎作为云和AI领域的领先者,在运用字节跳动技术对DeepSeek模型进行深入优化方面取得了显著成效。这一成果不仅提升了模型的核心性能,还通过一系列细致入微的措施,使得企业应用该模型时能更高效且更安全,因而受到了业界的广泛关注。

增强核心性能

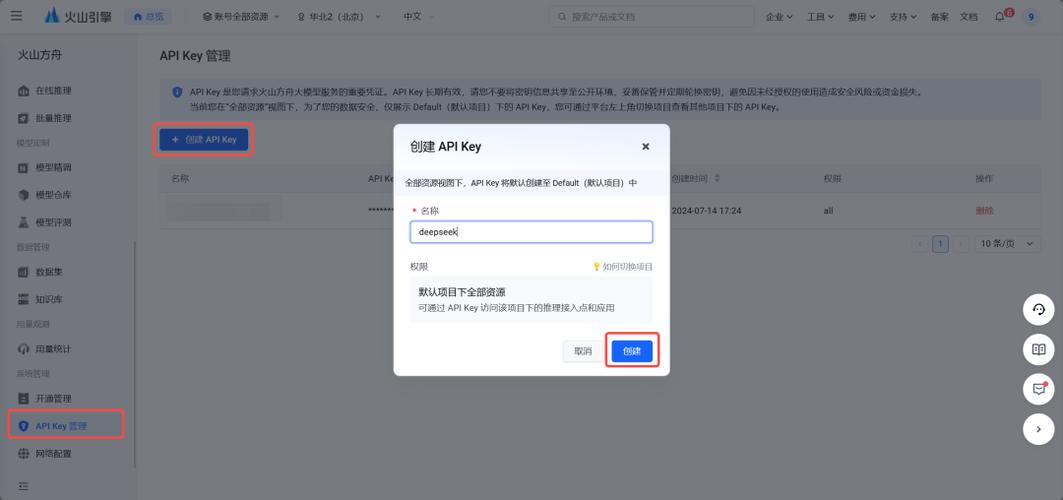

火山引擎基于字节跳动的前沿技术及丰富经验,不仅继承了DeepSeek原模型的性能,还对系统的承载能力、推理效率及部署安全性等关键环节进行了深度优化。这一举措旨在为用户提供一个持续高效、稳定可靠的使用体验,同时让企业和开发者能够更加顺畅地使用该模型。优化这些核心性能是一项挑战,火山引擎投入了大量技术资源和人力,并通过不断测试,最终实现了这一目标。

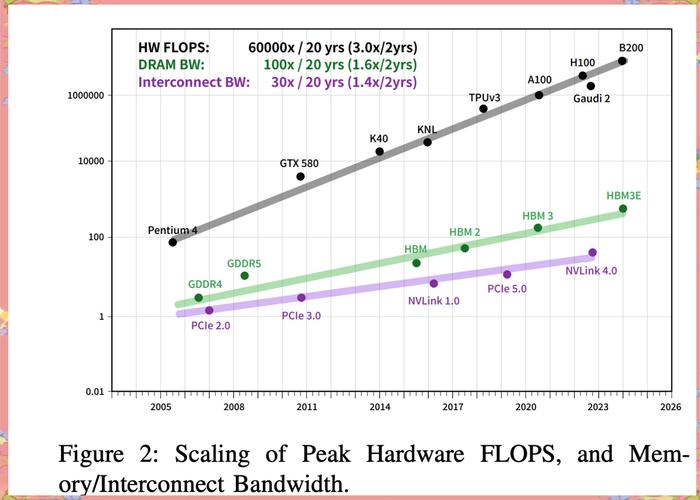

在优化阶段,火山引擎对各个层面进行了细致打磨。无论是模型的基础架构还是应用层面,亦或是数据传输与交互环节,每个细节都经历了深入的优化工作。这一系列举措旨在确保DeepSeek模型即便在高强度运行中,也能维持其稳定与高效的表现。

提高TPM规模

DeepSeek模型在企业应用中对于“高并发”的需求至关重要。火山引擎将初始的TPM值从80万显著提升至500万,此数值已达到全网之最。与目前主流的DeepSeek第三方服务商相比,火山引擎在TPM规模上展现出显著优势。如此庞大的TPM规模,有助于企业和开发者以更低的门槛在业务场景中运用DeepSeek全系列模型及豆包大模型1.5,推动更深层次、更高并发的创新应用。

企业受益匪浅。大规模TPM使得企业在同一时段内能处理更多任务,显著提升了工作效率。无论是处理大量数据,还是应对高并发业务,TPM均能轻松应对,为企业发展提供了坚实的保障。

提供离线配额

火山引擎除提供500万初始TPM外,还推出了全网独有的“50亿初始离线TPD配额”。该配额主要针对企业信息标记及高用量离线场景。在离线数据处理与分析过程中,企业可利用此配额,无需担忧数据使用限制,从而提高工作效率。

对于急需处理大量离线数据的企业而言,这无疑是一场及时的滋润。企业能够运用这一配额,对庞大的历史数据展开深入挖掘与分析,进而更深入地洞察市场走势与客户需求,从而制定出更加精确的发展计划。

优化推理调度

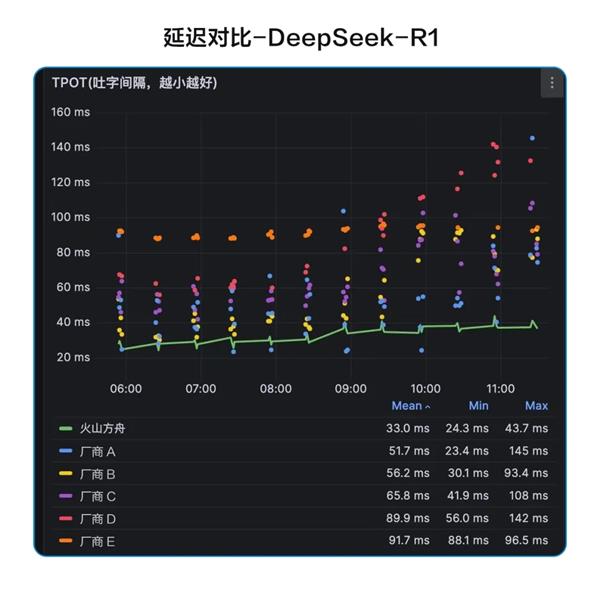

火山引擎通过运用自主研发的全栈推理引擎,对DeepSeek系列模型在算子、推理和调度层面进行了深度优化。火山方舟还具备全面的大模型调用监控与告警功能,确保了模型在高流量、低延迟和稳定性方面的需求得到充分满足。此优化使得模型在执行复杂任务时更加高效,显著提升了应用效能。

在具体应用场景中,无论是遭遇高访问量,抑或是处理繁复的业务流程,经过优化的模型均能迅速作出反应,精确地呈现输出。此举显著提升了企业和开发者的服务信赖度,使他们得以更集中精力致力于业务创新。

完善联网功能

联网搜索技术有效解决了大型模型将故事误作新闻的问题,DeepSeek因而能够获取全面及时的网络信息,从而增强了其回答的时效性和精确性。火山方舟在联网搜索方面实现了更深层次的创新,用户能够自定义内容来源和引用数量,并且能够进行联网搜索意图识别、文本改写等高级功能配置。这些功能使得大型模型的使用更加个性化,能够满足不同用户的多样化需求。

用户可依据自身业务需求与使用偏好,对大型模型进行个性化调整。此举可满足用户在特定领域信息搜集方面的需求,亦能实现输出内容格式的个性化要求。

保障模型安全

业界持续关注大模型的安全性,火山引擎凭借多种策略为企业AI应用构筑了安全防线。火山引擎PCC私密云在端到端应用中确保数据不被泄露,其安全防火墙能够有效防御DDoS攻击和提示词攻击,并能识别出违规内容。在针对DeepSeek R1和V3模型的安全性测试中,火山引擎成功将提示词注入攻击的成功率降至1%以下。

在数字化盛行的当下,数据保护显得尤为关键。火山引擎采取的一系列安全措施,保障了企业在运用大型模型时免受数据泄露及恶意攻击的困扰,从而确保了企业数据安全与业务的持续稳定。

您如何看待火山引擎对DeepSeek模型进行的最新改进,这一举措可能对大型模型应用领域带来哪些变化?欢迎在评论区分享您的见解。同时,请不要忘记为本文点赞及转发!