AI幻觉初揭秘

AI生成内容展现出一种引人注目的现象——幻觉,即AI输出的信息表面上看似合理,但实际上存在错误,甚至编造了不存在的细节。比如,当要求AI解释某一边缘学科的理论时,它可能会提供一系列看似专业的描述,但这些描述实际上缺乏依据。这种现象并非AI有意为之,而是由于AI在执行任务时特有的处理方式所导致。

学生在面对考试中的难题时,会运用所学知识进行推理,以寻找答案。类似地,人工智能在信息不足时,会根据其训练数据执行推论和补充。然而,这与那些虽广泛阅读却未能深刻领会书籍精髓的智者相仿,AI仅通过文字间的统计关系进行内容推断,这或许会引发幻觉,进而带来潜在风险。

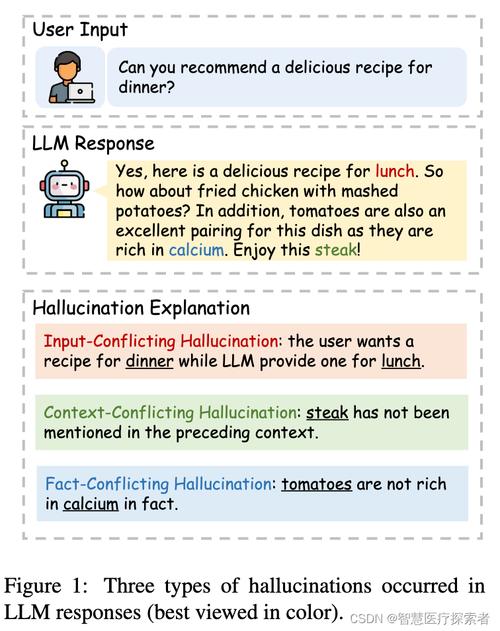

AI生成内容机制

GPT等语言模型通过大量训练数据掌握文字间的统计规律。其核心功能是依据上下文预测最可能出现的词汇。这一过程并不涉及对问题的深入理解。本质上,这类模型旨在最大化概率,以生成内容,而非进行逻辑推理。

输入特定情境的文字描述后,AI会根据训练过程中类似描述出现的频率来预测后续内容。这一预测过程不涉及对情境的深入理解或细致分析,纯粹基于概率计算。然而,这种处理方法导致错误和误导的风险也随之上升。

“猜错”引发的后果

模型在判断时偶有失误,若这些失误起初微小,便可能逐渐构建出一个完全虚构的叙述。例如,在回答关于“上海有哪些特色美食”的问题时,模型可能错误地将非上海地区的美食归为上海特色,甚至创造出一种并不存在的上海独有美食。

人工智能因缺乏现实经验,其认知主要依赖训练数据。然而,这些数据无法全面覆盖所有信息,且可能包含错误。这种认知局限使得人工智能在回答问题时常出现错误,并有可能产出与事实不符的虚构内容。

“过拟合”的影响

训练期间,大型模型的参数量庞大,常遭遇“过拟合”现象。这种现象导致模型过度记忆错误或不相关资料,对训练数据中的杂音和异常反应强烈,从而引发幻觉。以历史事件分析为例,模型可能将不同时期的细节混淆。

AI学习过程中可能遭遇“过拟合”现象,导致学习资料复杂化,分类变得不清晰,难以形成准确的判断标准。这一状况与大脑处理繁杂信息时易出现的思维及表达混乱相似,进而可能减少输出结果的精确度。

有限范围的理解偏差

技术限制使得即便是大型模型,其处理能力也只能达到64k或128k的tokens。但这一能力并未提升其对文本的理解水平。这就像通过狭小的窗户阅读,只能看到部分文字,难以全面领会全文的深层意义,进而可能引发理解上的误差。

在处理繁复的长篇文本时,AI可能面临全面理解全文的挑战。这可能导致其解读仅基于文本的部分内容。因此,AI的回应可能与问题的整体意义存在出入。在极端情况下,甚至可能产生不准确的信息。

应对AI幻觉之法

在AI对话环境中,提问应当力求明确和完备,避免问题含糊不清或过于宽泛。明确具体的问题通常能促得更准确的回复。比如,针对“2024年东京将举办哪些著名音乐会”的询问,与“东京有哪些活动”相比,前者更有可能获得具体的答案。

提问时,需确保提供详尽的背景资料或情境说明,以此降低误解和错误推断的可能性。在咨询医学治疗方案时,请详细阐述患者的症状和病史,以便AI提供更为准确的建议。在与AI互动过程中,您是否遇到过令人感到意外的“AI幻觉”现象?