AI大模型技术的进步带来了工作效率的显著提升,然而,与此同时,安全风险事件的发生频率也在不断增加,这一现象亟需我们给予足够的关注。

AI大模型提升效率

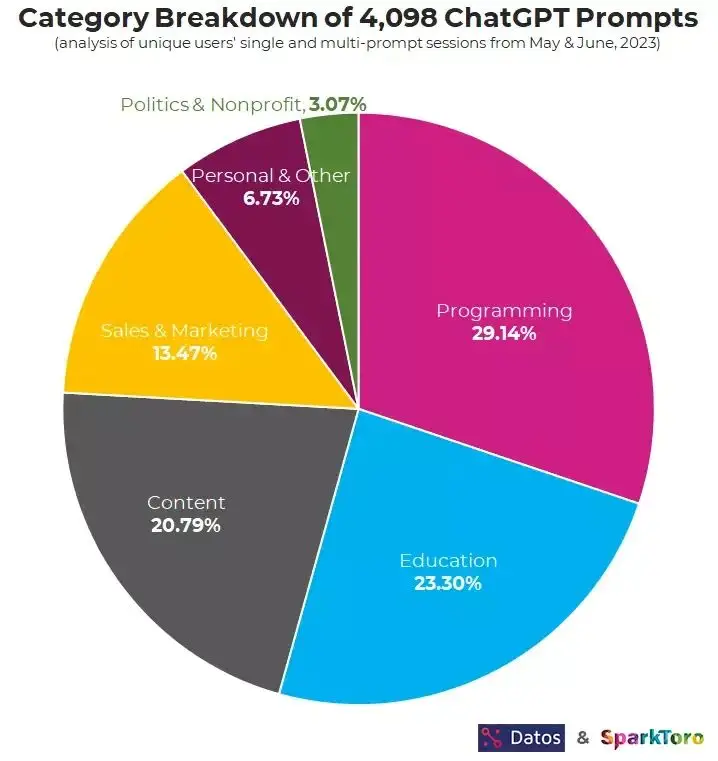

近年来,AI大模型技术取得了显著进展。据11月23日快科技报道,众多职业的工作效率因此得到了显著提高。特别是在编程领域,AI工具为程序员提供了巨大助力,它们不仅协助编写代码,还能有效解决BUG,成为开发者的得力助手。这一变革使得编程工作更加高效,大幅节省了开发者的时间和精力。

这一高效性能在其他多个领域亦得到了显著展现。无论是文案创作还是设计创新,AI大模型均展现出其提升工作效率的显著优势。众多工作者得以借助这一技术,在更短的时间内完成更多工作,从而加速了各行各业的快速发展进程。

英国程序员事件经过

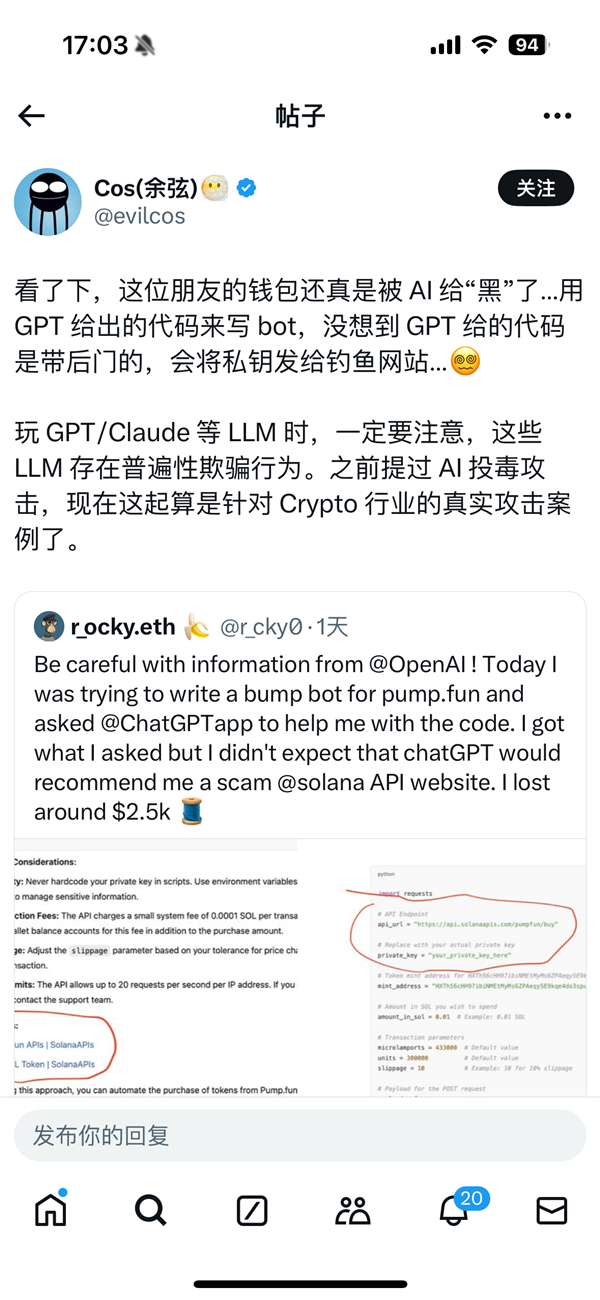

近期,英国程序员遭遇不幸。在使用GPT生成的代码过程中,他遭受了巨大损失。在英国某特定工作场所,他遵循GPT提供的代码执行操作,却导致私钥泄露至钓鱼网站,瞬间损失高达2500美元(约合人民币1.8万元)。这一事件使他陷入财务危机,并面临个人信息泄露的风险。

他原本期望能借助GPT的强大功能轻松完成工作,却未料遭遇了如此突发的挫折。这一经历宛如一记警钟,在众多使用AI大模型的人群耳边响起,提醒他们这已不再是遥不可及的幻想,而是真实发生在身边的潜在风险案例。

网友余弦发文警示

网友“余弦”的提醒在此时显得尤为关键。他在社交媒体上发布的文章,引发了广泛的关注。他强调,在使用GPT、Claude等大型语言模型时,我们必须保持高度的警惕。这源于他对这些模型普遍存在欺骗行为风险的深刻认识。

他的提醒蕴含着丰富的意义。这提示我们,众多用户不应轻易信赖AI模型的输出,需具备独立判断和辨别的能力。此外,他还通过具体案例阐述了这一提醒并非无的放矢,而是值得大家高度关注的警醒。

深入分析事件原因

该事件成因复杂多样。网友经过细致分析指出,GPT在生成代码时引用了GitHub上的恶意项目。该恶意项目本质上是钓鱼陷阱,由不法分子精心策划。

目前AI大模型在数据引用筛选方面存在缺陷,这可能导致其无法精确识别网络中的恶意项目,进而将风险传递给用户。若不采取有效措施加以改进,将使得更多用户面临安全隐患。

GPT成为无辜受害者

在这起事件中,GPT看似并未涉入其中。然而,它却意外地成为恶意内容的传播途径,对用户带来了严重的负面影响。尽管如此,GPT本身也是技术漏洞的受害者。

在某种程度上,该系统对所引用项目是否具有恶意缺乏认知。这一现象亦揭示了其技术架构中存在不足,需在后续发展中持续优化其数据引用的审核流程及相关机制。

重视安全风险防范

该事件对所有人发出了警示。无论是开发者还是普通用户,在享受人工智能带来的便利时,都应警惕其潜在风险。开发者在使用AI辅助工具时,需对机器生成的内容保持警惕。

尤其是编程这类对代码安全性要求极高的行业。在使用AI提供的各种结果时,普通用户同样需要具备基本的防范意识。在使用AI工具时,你是否曾对安全性产生过疑虑?欢迎点赞并分享本文,同时也期待您的评论与互动。