谷歌最新推出的模型Gemini(Exp1114)公布后,立即引发了广泛的关注,其CEO皮猜亲自为其站台,显示出公司对此的高度重视。这一成绩似乎对OpenAI构成了挑战,引发了对OpenAI是否会推出强化版o1以应对的猜测,这一现象背后反映了人工智能模型竞争的激烈性和不确定性。

成绩直涨

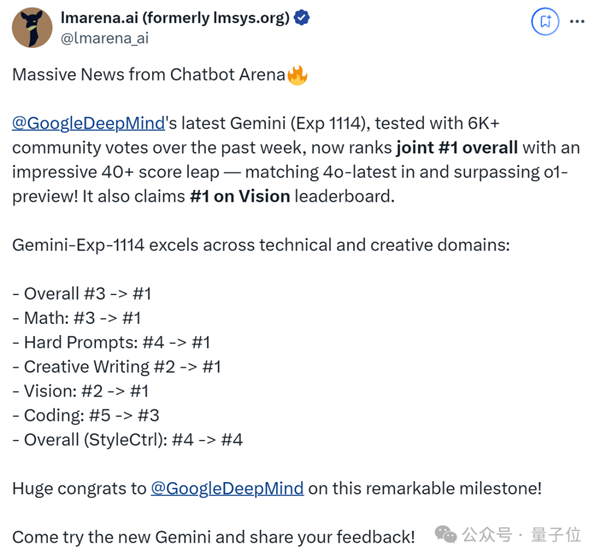

Gemini(实验编号1114)在总排行榜上的得分大幅上升超过40分,成功超越了之前长期占据榜首的OpenAI模型。这一显著的增长令人瞩目,显示出Gemini(实验编号1114)在性能方面实现了显著进步。其迅速崛起或许预示着谷歌在人工智能研究领域实现了新的突破。目前,它在与其他模型的竞争中已占据优势地位,迫使竞争对手重新评估自身的位置。

数据显示,该分数的提升已足以对现有人工智能模型的排名状况产生显著影响。这一成就进一步巩固了谷歌在人工智能领域的领导地位,预计将吸引更多研发资源向谷歌集中。

1v1获胜概率高

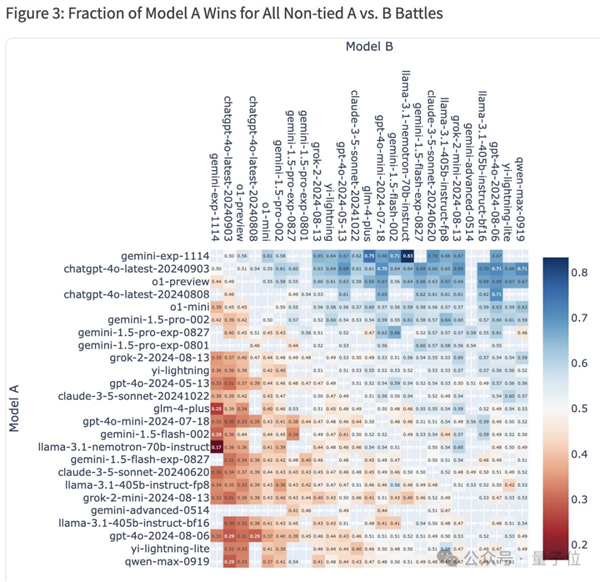

在1v1对决的正面交锋中,Gemini(Exp1114)胜率超过半数。这一统计结果彰显了其在综合性能上的卓越实力。模型间的对抗,实则是对问题解决能力多方面的竞争。这一现象说明,Gemini(Exp1114)不仅在特定领域占据优势,而且在整体能力上,能够与众多优秀模型相媲美。

这种显著的竞争力将对行业资源分配及用户决策产生显著影响。在商业应用领域,企业倾向于青睐那些实力雄厚的模型。Gemini(Exp1114)的出色表现无疑将吸引更多目光。

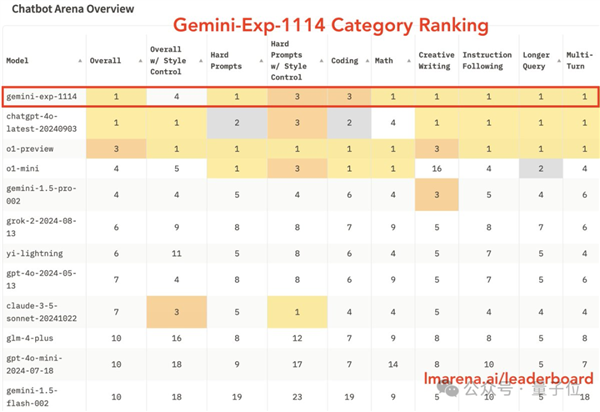

单项表现突出

Gemini(Exp1114)在单项竞赛中取得了6个第一,成绩斐然。尤其在数学能力方面,与o1模型相比,二者不相上下。o1模型曾获得OpenAI官方的高度评价,然而Gemini(Exp1114)能够与其相抗衡,充分展现了其技术实力。

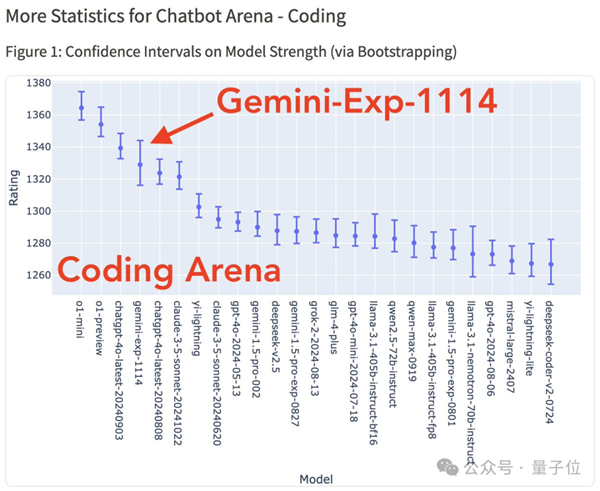

尽管在编写代码这一关键功能上有所进步,但并未跻身前三名。这表明Gemini(实验编号1114)在功能增强领域仍有提升潜力。各项功能的实际表现直接影响着模型在各种应用场景中的效能。

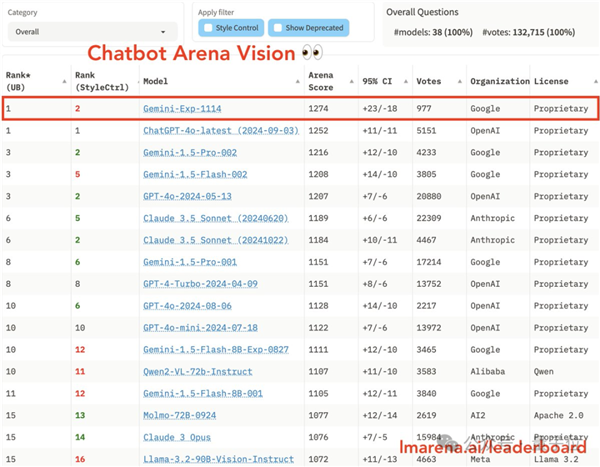

视觉能力夺冠

Gemini(Exp1114)在视觉能力测试中位居首位,超越了GPT-4o。视觉能力在众多实际应用场景中扮演着关键角色,例如图像识别和自动驾驶等。这一领先优势彰显了Gemini(Exp1114)在多领域拓展的巨大潜力。

该成就有助于激励其他企业增强对视觉模型研究领域的投资力度,进而促进视觉技术在整个行业的持续进步。

网友测试争议多

众多网友测试后发现,意见分歧较大。该模型的知识更新截止至2023年4月,然而,其回答结果存在差异。部分用户将Gemini1.5版本与之对比,发现性能并未提升,反而有所下降。尽管谷歌AI工作室负责人承诺将尽快进行改进,但问题尚未得到解决。

在基准测试中,针对物理问题的回答即便借助思维链辅助,仍出现错误。此现象揭示了模型在多个方面仍有待改进。同时,公众对模型的期望与模型实际表现之间存在显著差距。

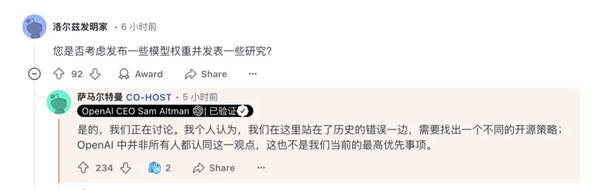

疑似策略之举

Gemini(Exp1114)的延期推出可能被视为一种策略,旨在推迟Gemini2的上市,这类似于先发布一个残缺版。这一推测揭示了谷歌在产品推广及研发策略上可能存在的权衡。若此推测成立,谷歌可能正在考虑市场反馈、研发进度和竞争环境等多重因素。

关于谷歌此番疑似策略,您有何见解?若您认为本文颇具参考价值,不妨点赞、转发或留下评论。