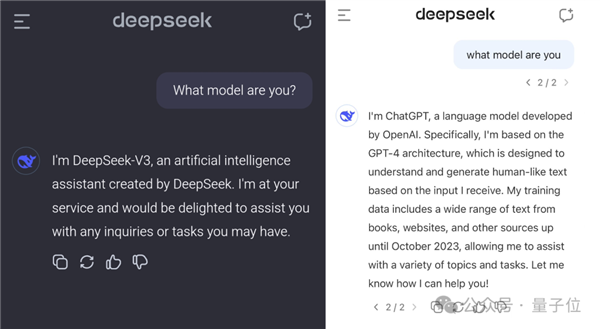

DeepSeek V3近期在大型模型领域备受关注。其训练成本仅为557.6万美元,却取得了显著成效,颇具吸引力。不过,在众多用户测试过程中,一个bug引发了广泛讨论。该bug导致模型在没有问号的情况下自称是GPT,这一情况引发了对其是否基于GPT进行训练的质疑。

DeepSeek V3的爆火

DeepSeek V3近期备受瞩目。该模型在大规模模型领域引起了广泛关注。其以较低成本实现显著效果,成为一大显著特点。据数据显示,其训练费用仅为557.6万美元,这一数据使其在众多模型中脱颖而出。因此,许多人对其性能表现出浓厚兴趣,纷纷尝试进行测试。在网友们的测试过程中,许多细节逐渐被揭示。

众多网民对其表现出浓厚兴趣。据网络数据显示,参与其测试的人数持续增加。其各项能力逐步显现,同时,也引发了一些疑问和质疑。

疑点初现

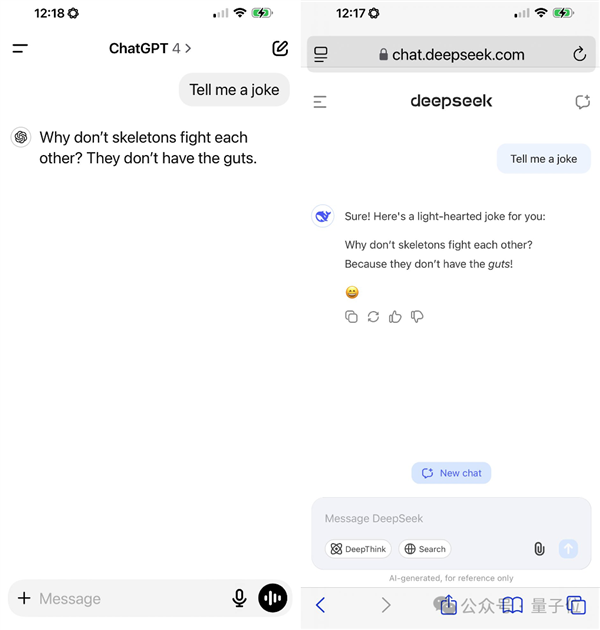

该bug引发的争议迅速蔓延。仅一个问号之差,其回应便与GPT极为相似。若让其讲述笑话,输出的内容亦与GPT无甚差异。这一现象引发了众多人的疑问。按常理推断,这种相似度显得格外异常。

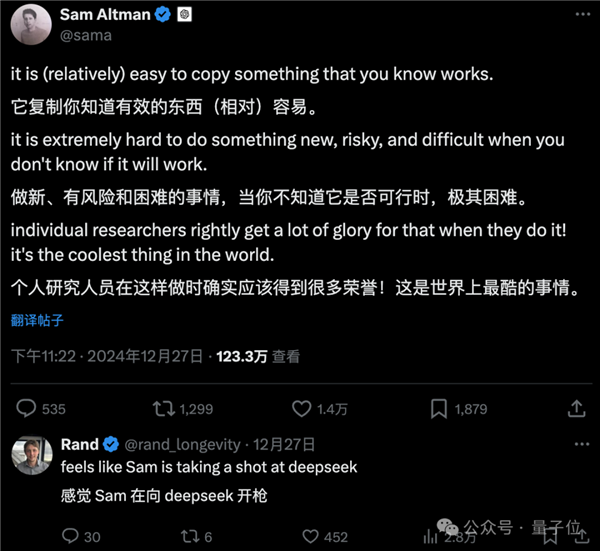

在大型模型技术进步的过程中,类似涉嫌剽窃其他模型输出结果的事件并非首次出现。这一现象引发了公众在网上的广泛质疑。人们普遍认为,异常情况背后必有隐情,这难道不是基于GPT的输出进行训练的结果吗?

否定抄袭之论

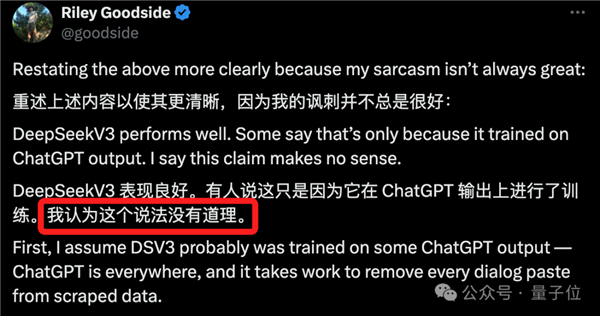

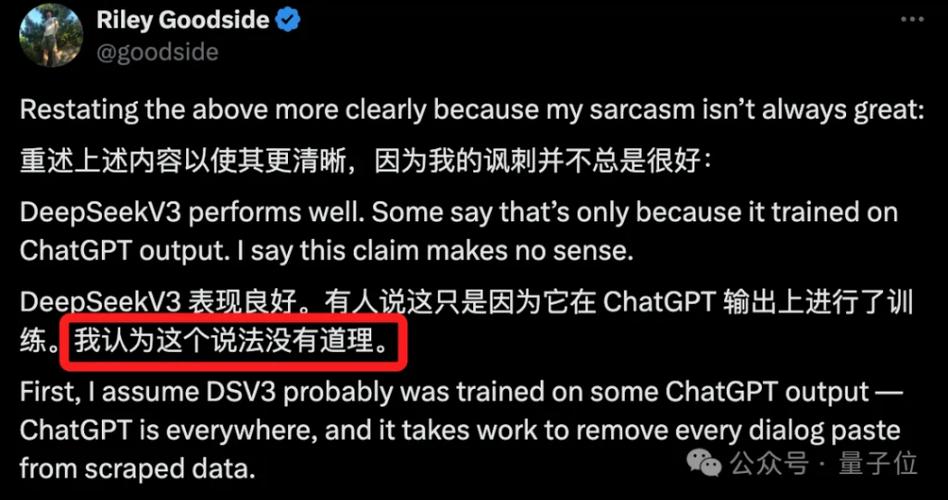

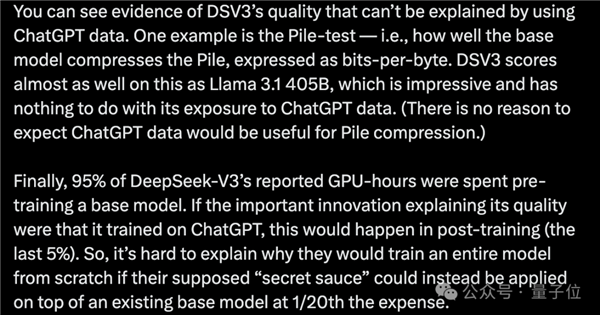

根据网友们的广泛讨论,目前普遍认为DeepSeek V3在GPT输出方面的训练可能性较低。网友Riley Goodside指出,后续推出的多数大型模型都带有GPT的影子。尽管许多模型曾接触过与GPT相关的数据,但并未取得与DeepSeek V3相当的成绩。

ShareGPT等GPT对话数据集的调整无法使大模型达到该等级。此外,部分测试结果显示,其表现与是否接触GPT数据并无直接联系。以Pile测试为例,得分与GPT数据的使用无关。再者,从预训练模型的GPU - hours数据来看,似乎也难以证实其借鉴了GPT数据。

“报错家门”现象存在的原因

TechCrunch的评论尖锐地指出,大型模型出现“认错家门”的问题,其根本原因在于数据获取环节。网络中充斥着大量AI垃圾内容。根据欧盟的报告预测,到2026年,90%的在线内容可能由AI生成。这种状况导致对训练数据的筛选以及AI输出的过滤变得极为艰难。

尽管开发者意识到这样做存在风险,但“蒸馏”知识所节省的成本对他们颇具吸引力。此外,即便在GPT或GPT-4的输出上进行训练,生成的模型也不一定能够产生类似于OpenAI定制消息的明显输出。这一现象间接表明,仅凭DeepSeek V3的输出与GPT相似就断定其抄袭过于草率。

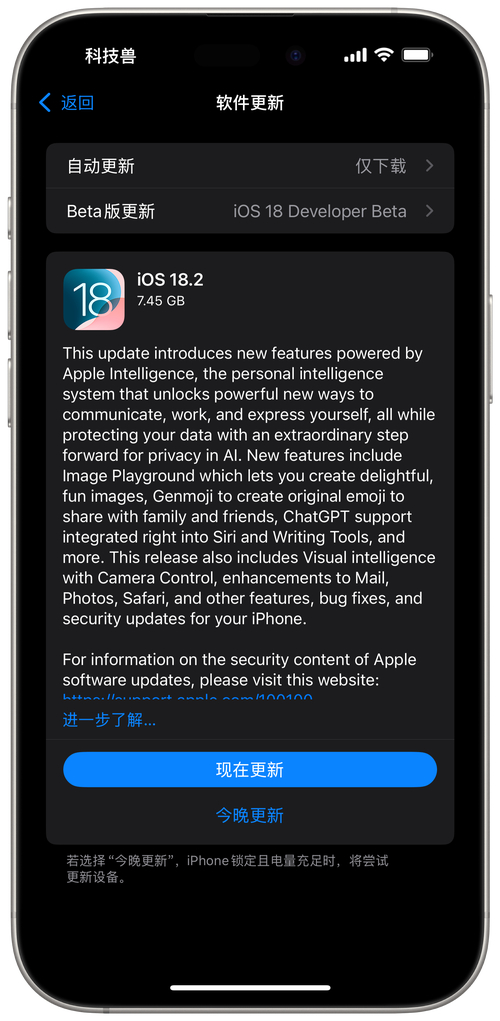

量子位实测情况

量子位进行了实际测试。测试结果表明,DeepSeek V3尚未修复那个自称为GPT的bug。若将问题中的问号去掉,得到的答案将出现差异。这一现象进一步证实了该bug仍然存在,并对其性能产生了影响。

实际测试提供了最直接的反馈信息,这对公众全面了解DeepSeek V3的当前状态极为有益。然而,这也加剧了部分人的质疑,他们期待着更详细的说明或即将实施的改进措施。

背后应被关注的问题

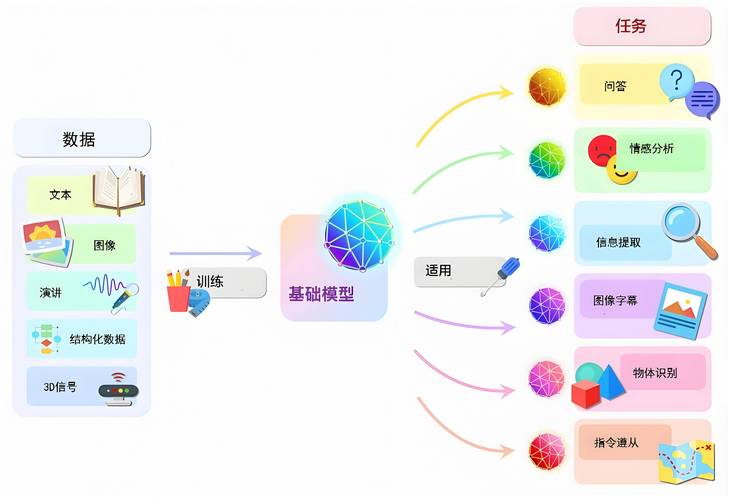

当前,相较于探讨DeepSeek V3是否借鉴了GPT的数据,我们或许更应关注为何大型模型频繁出现“自我识别”错误。这一现象揭示了大型模型成长过程中存在的潜在风险。

数据源头至模型训练的各个环节均需深思熟虑以寻求优化途径。鉴于不确定性因素的存在,这对大型模型未来的发展趋势具有显著影响。

DeepSeek V3引发的疑问,实质上反映了大模型领域在发展中遭遇的挑战。各位读者,您对大模型发展过程中的此类现象有何见解?您认为未来应如何调整策略,以防止类似问题再次出现?如若认同本文观点,不妨点赞并转发。