自博弈策略崭露头角

自博弈策略作为强化学习领域的重要手段,其核心思想与自对抗生成网络(GAN)相近,即通过智能体与自身副本或历史版本进行对抗性游戏来推动发展。该策略先前在游戏、机器人、生物工程等多个行业得到实践。近期,苹果公司将其引入自动驾驶领域,引发了行业的深刻变革。

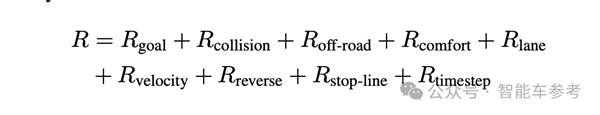

苹果公司对自动驾驶技术的研究中,采纳了简化的激励机制。这一机制不依赖真实数据,而是利用大规模模拟数据。借助此方法,算法得以不断优化和提升。

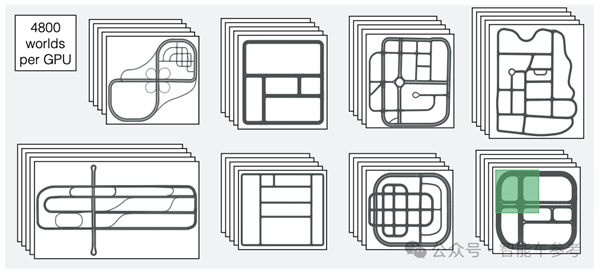

模拟数据海量产出

苹果公司通过强化学习技术,在博弈领域取得了显著成果,仅用10天时间便收集了高达160亿公里的模拟驾驶数据。依托公共云平台上的8张A100芯片,该系统每小时可模拟学习44亿次状态变化,这一数据相当于积累了720万公里的实际驾驶经验。相较于使用真实数据,其处理速度提升了36万倍。

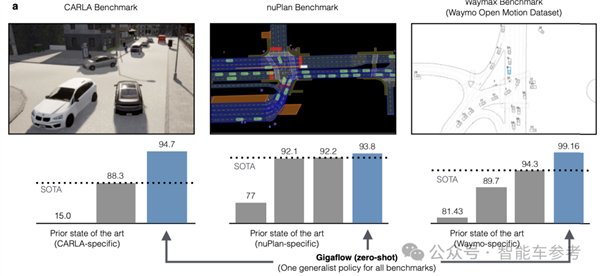

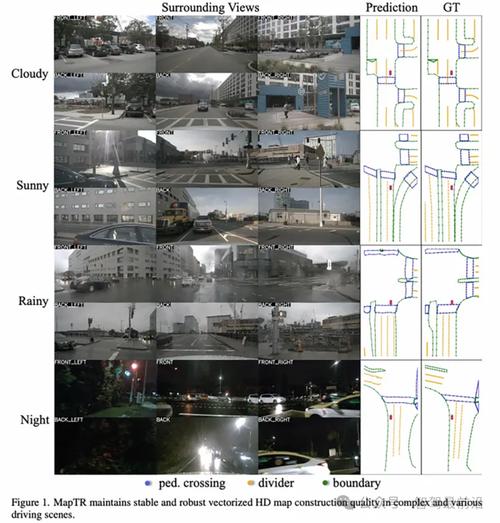

成本非常低廉,大量模拟数据证实,成果已达到行业领先水平。数据内容详实,涵盖了不同地图、驾驶条件、交通密度以及评分标准等多个方面,充分体现了苹果技术的广泛适用性和出色的稳定性。

核心成果GIGAFLOW

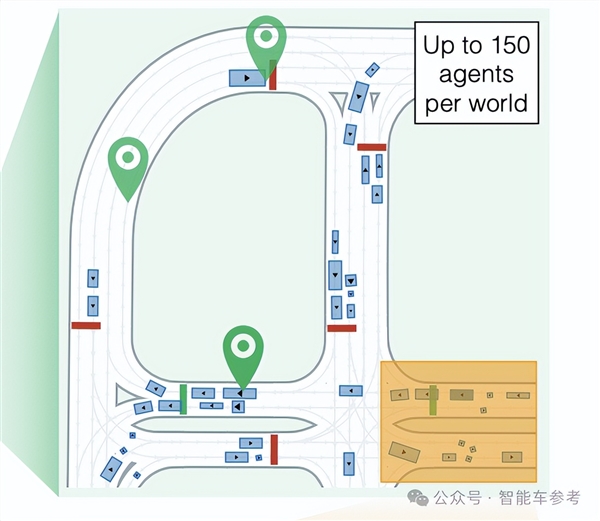

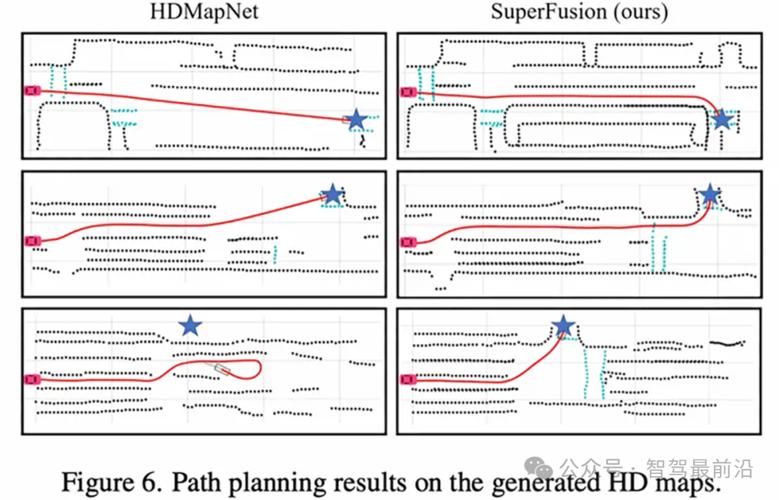

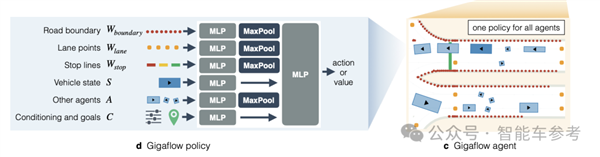

苹果公司通过采用GIGAFLOW模拟器,在较低成本下实现了卓越的性能提升。该模拟器属于批量模拟器范畴,专注于采用通才策略,并已构建了众多GIGAFLOW World。这些模型可看作是简化版的世界模型。

苹果公司的研究论文对这一理论进行了深入阐述,指出该理论不仅对自动驾驶技术具有适用性,而且对具身智能等多个领域可能带来的应用前景进行了初步展望。论文亦明确指出了当前研究存在的不足。

智能体模拟训练

在GIGAFLOW World中,地图所涉道路总长度达到136公里。行驶期间,系统会随机生成1至N个智能体。这些智能体必须通过自我博弈实现各自目标。尽管如此,模拟训练中的智能体仍可能引发交通事故。苹果公司数据显示,此类事故的频率大约为每行驶300万公里发生一次。

资深驾驶员在国内的交通事故率约为每行驶三万五千公里出现一次。实际上,实际道路的复杂性大大超过模拟环境。这一情况反映出模拟驾驶训练与实际驾驶操作之间存在显著差异。

参数更新算法优势

GIGAFLOW在参数更新阶段采用了OpenAI在2017年提出的近端策略优化算法,即PPO。该算法对策略更新的幅度加以控制,有效简化了训练过程,并提高了训练的整体效能。

借助该算法的支持,苹果公司在自动驾驶算法的研究上实现了持续而稳定的进步,进而为更高级的自动驾驶技术打下了坚实的根基。

应用展望与现存问题

该研究论文不仅呈现了最新的学术进展,而且对消费级机器人、工业应用和网络游戏等多个领域的应用潜力进行了展望。尽管如此,目前仍存在一些亟待解决的问题。

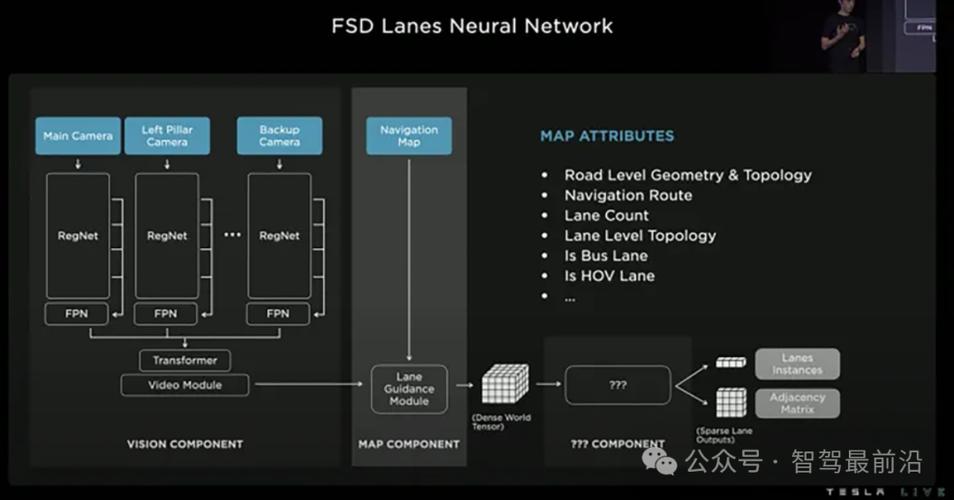

在技术层面上,感知处理过程较为简单,目前主要关注的是规划和决策环节;至于工程应用方面,大规模的自博弈训练对资源需求极高,实施过程中必须考虑计算成本。对于苹果公司新推出的自动驾驶技术,您对其未来的广泛应用前景有何看法?