人工智能领域正经历快速的发展,特别是大型模型技术取得了显著进展。尽管如此,目前面临效率增长和资源使用效率的瓶颈。近期,预计一系列关键的深度研究举措将有效减轻这些挑战。

开源壮举

2月24日,首届“开源周”活动期间,深度求索(DeepSeek)推出了首个开源代码库——FlashMLA。此举在全球人工智能领域引发了强烈关注,吸引了众多行业专家的密切注意。众多开发者与学者齐聚一堂,共同目睹了FlashMLA开源代码库的问世。

FlashMLA的问世,为人工智能领域带来了新的生机。这一技术有望克服大型模型在成长阶段遭遇的诸多难题,助力AI技术迈向更高层次的应用。此外,其开源特性也为更广泛的群体提供了参与优化与进步的平台。

创新优化方案

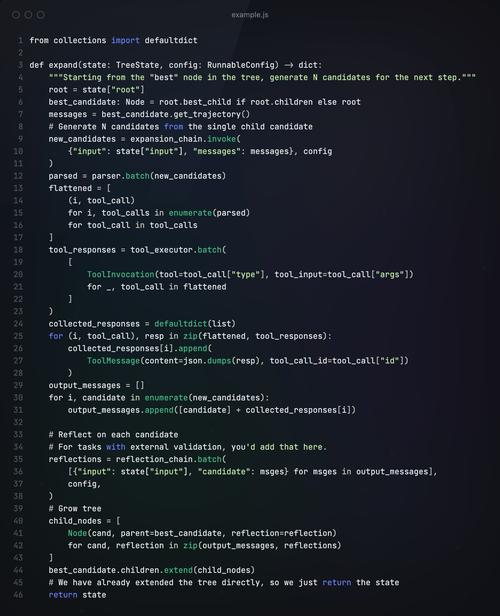

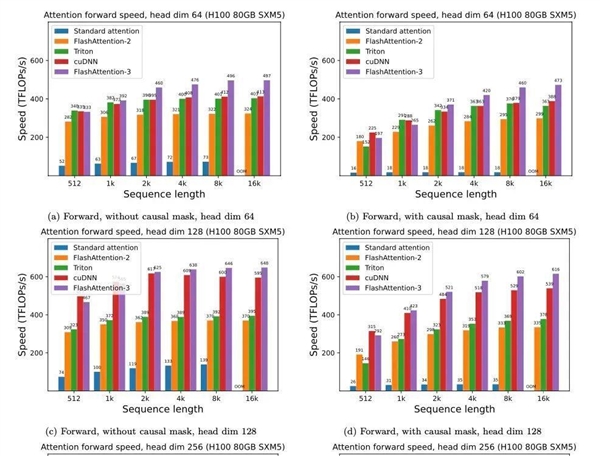

FlashMLA是一种专门为大型语言模型优化的高效策略,尤其适合H800等配备GPU的设备。该策略显著提升了模型的运行速度。过去的方法未能充分利用GPU的算力,如同满载但仍有空间的车,造成了资源的极大浪费。

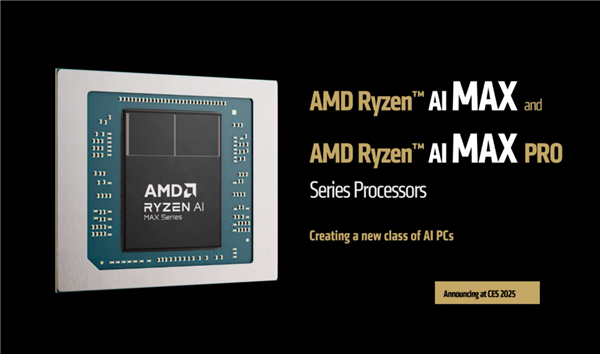

FlashMLA专注于性能优化,它通过采纳前沿的动态资源调配与内存强化技术,全面激发Hopper GPU(如H100)的计算潜能。在保持硬件配置不变的前提下,该设备实现了更高效的运算速度,为大型语言模型的稳定运作提供了坚实的保障。

算力效益双提升

FlashMLA在算力调用领域处于领先。过去,面对不同长度的序列,GPU的并行计算潜力常被忽视。FlashMLA成功解决了这一问题。它显著提高了GPU的算力利用率,正如卓越的管理者激发员工潜能一般。

该优势显著降低了成本,使得用户仅需较少的GPU资源即可完成同等规模的作业。这一改变有效减轻了使用大型模型的经济压力。对于众多开发者和企业来说,这无疑带来了积极且正面的影响。

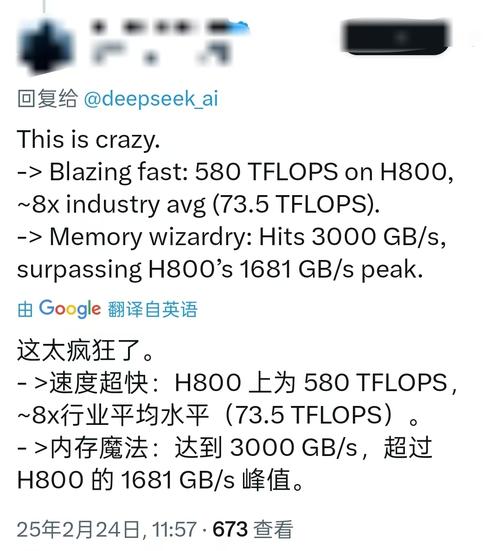

推理速度飞跃

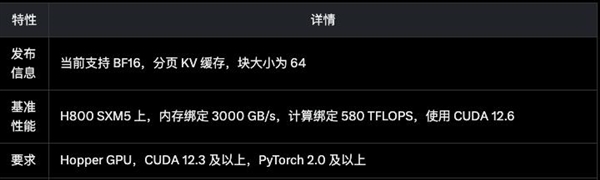

测试数据表明,搭载CUDA 12.6的H800 SXM5平台在FlashMLA性能方面表现出色。在内存资源紧张的情况下,其速度可达3000GB/s;而在计算资源受限时,其峰值性能更是达到了580 TFLOPS。这些优异的性能显著提升了FlashMLA在大规模模型推理速度方面的表现。

速度的加快,对聊天机器人及文本生成等即时任务而言,宛如为赛车更换了性能更优的引擎,显著增强了用户的使用感受。

多元应用场景

FlashMLA的应用范围十分广泛。在聊天机器人、文本自动生成和实时翻译等对响应速度和数据处理能力要求极高的实时生成任务中,FlashMLA表现优异。该技术能够确保信息的快速、精确输出。

GPT和BERT等大型语言模型在推理任务中展现出强大的辅助作用,大幅提高了推理速度。此外,这些模型在成本管理上同样表现出色。尤其在中小企业及硬件资源受限的环境中,它们为这些单位创造了构建大型模型的新可能。

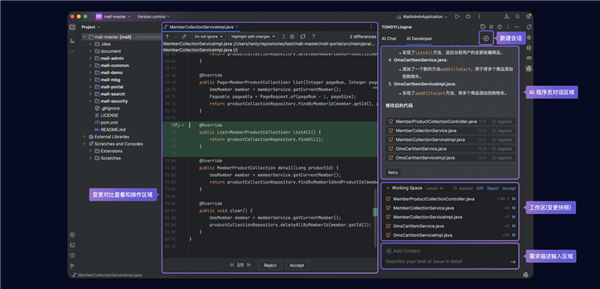

适配本地部署

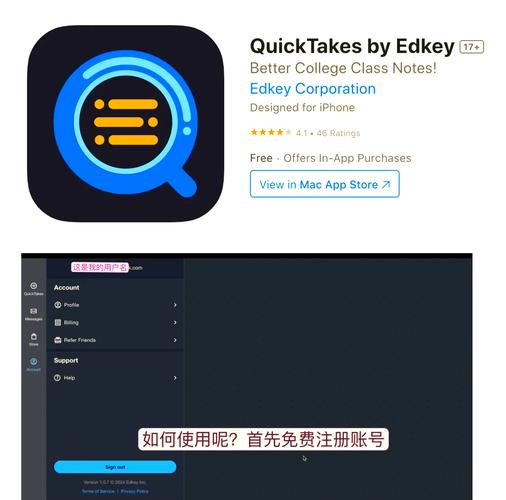

FlashMLA可在GITHUB平台找到,操作简便。该工具适合拥有消费级显卡的用户使用。用户能够充分利用个人电脑的硬件资源,在本地安装DeepSeek - R1(INT - 4)模型。此模型能满足日常办公和学习的需求。

影驰最新发布的GeForce RTX 50系列显卡,适用于本地部署。该系列显卡基于NVIDIA的Blackwell架构设计,并配备了第二代Transformer引擎。它引入了4位浮点(FP4) AI技术,显著提升了大型语言模型的推理与训练效率,成为个人用户提升工作效率的有力助手。

业界普遍关注FlashMLA在人工智能大型模型发展中的趋势,社会各界对此看法不一。我们期待您的评论、点赞及文章分享!