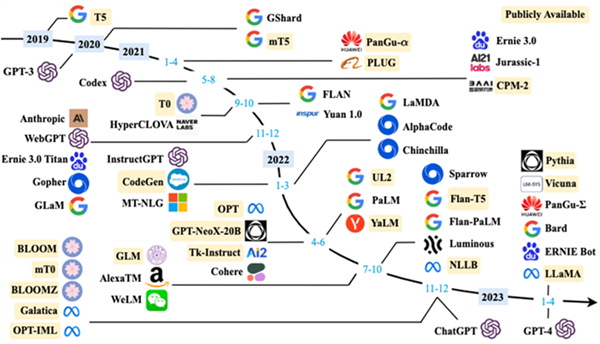

模型亮相引热议

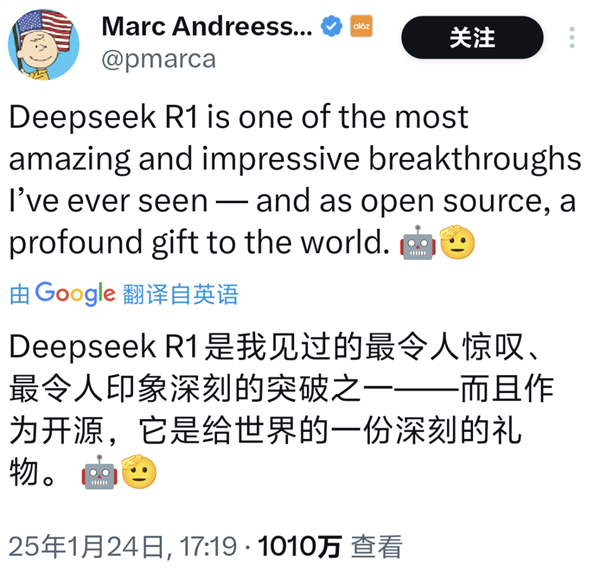

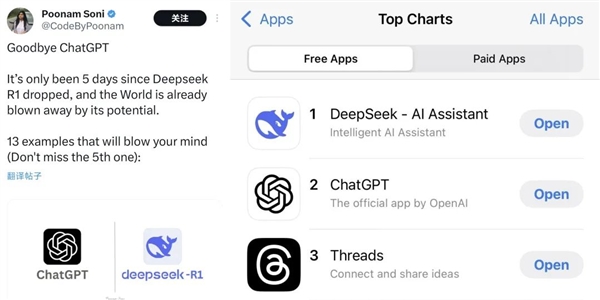

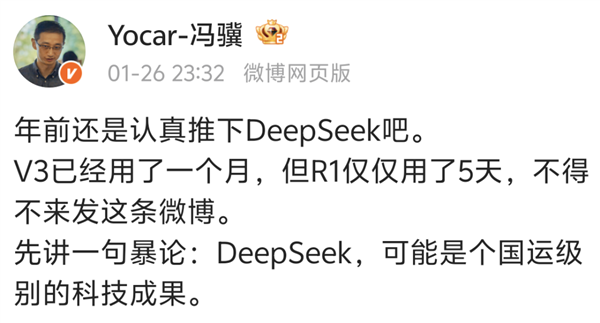

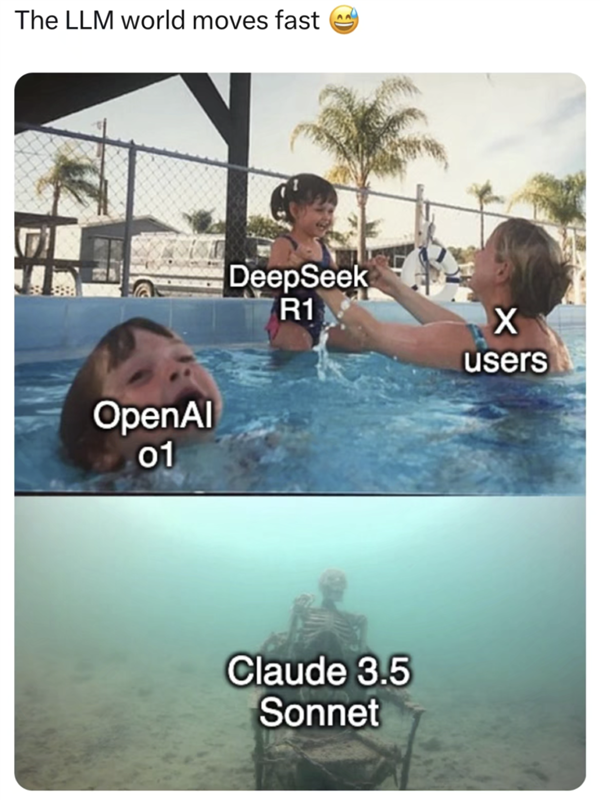

近期,DeepSeek团队推出了名为DeepSeek - R1的重要模型。这一发布犹如巨石入湖,激起了广泛的关注。之前,V3模型已让硅谷对中国的AI技术刮目相看,而DeepSeek - R1的问世则可以说是直接打破了局面。该模型实力非凡,与OpenAI的o1模型不相上下,一经公布,其热度迅速超越了前作。

该模型发布后,立刻在人工智能领域受到了极大的关注。众多专业人士纷纷投入研究,并对之展开热烈讨论。众人对于这个新兴的大模型所具有的独特特点表现出浓厚兴趣。

创意源于年轻开发者

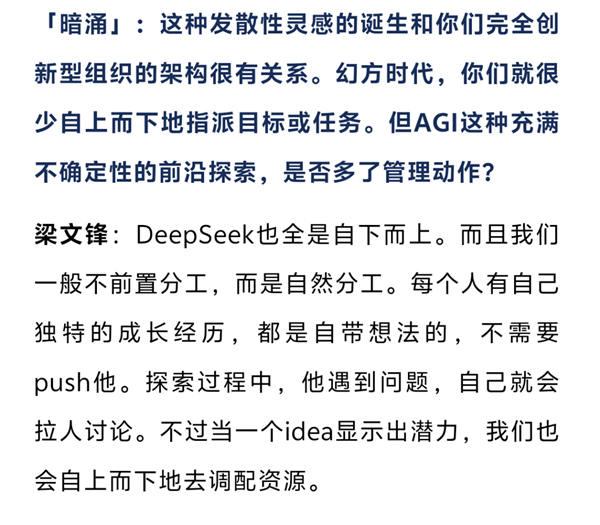

审视DeepSeek过往的V2和V3版本,我们发现其核心的多头注意力机制最初源自一位年轻开发者的新颖想法。随着团队成员的共同努力,他们围绕这一想法深入研究,持续优化方案,最终使得该技术得到完善,并被成功应用于模型之中。

该年轻开发者勇于突破的精神为团队注入了新的灵感,同时为后续模型构建打下了坚实的基础。团队成员的共同努力将创意成功转化为实际成果。

推理模型核心强化学习

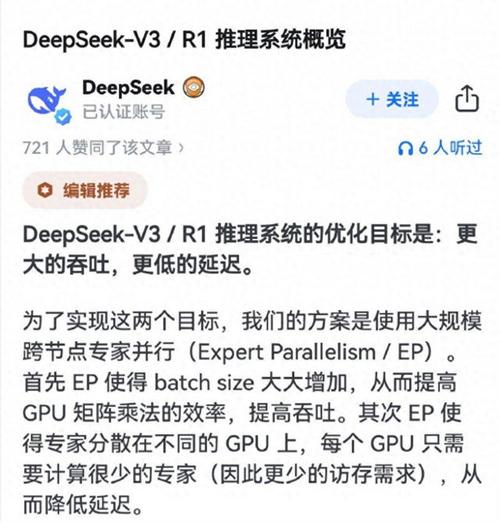

传统大模型训练强调对标注数据进行微调,以使模型能模仿人类标注的答案进行交流。DeepSeek的独特之处在于,其推理模型的核心技术基于强化学习。他们采用GRPO算法对模型的回答进行评分,并持续优化,这一过程完全未采用SFT技术。

DeepSeek进行了这一创新训练方法的尝试,这一举措为大模型训练开辟了新的路径和思考维度,揭示了超越传统途径的更多潜在选择。

R1 - Zero版本的突破

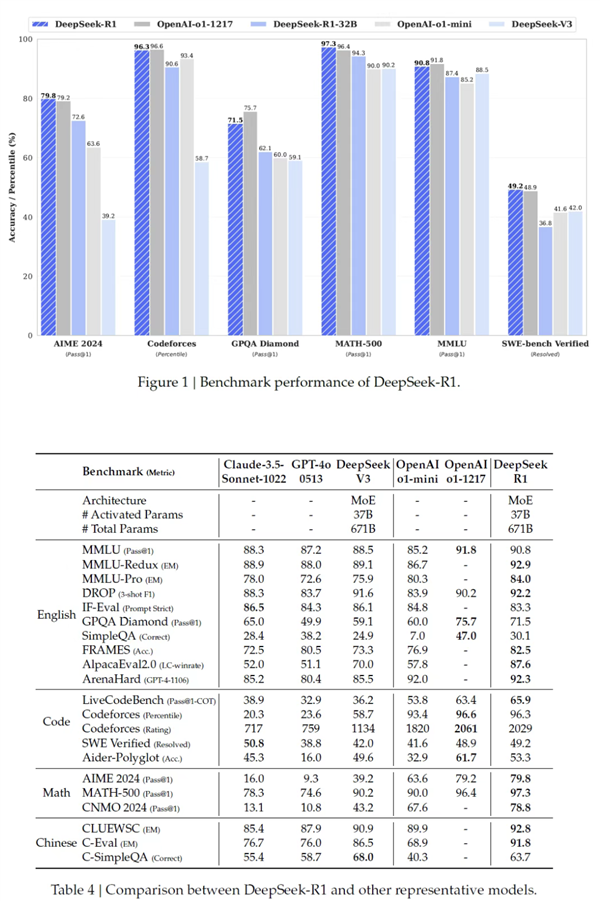

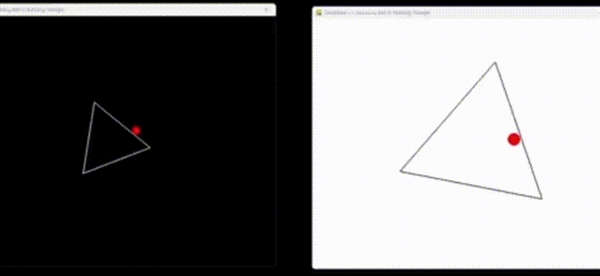

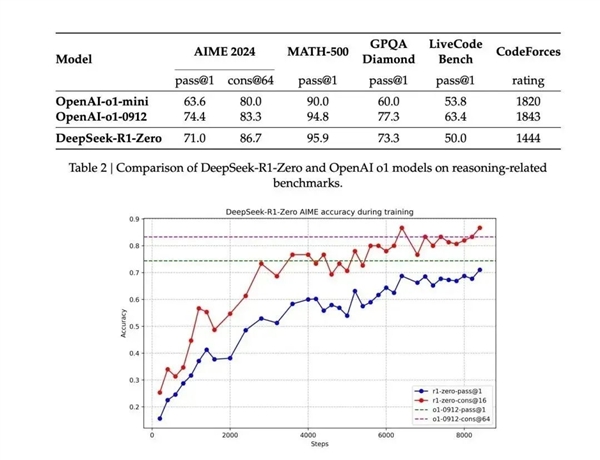

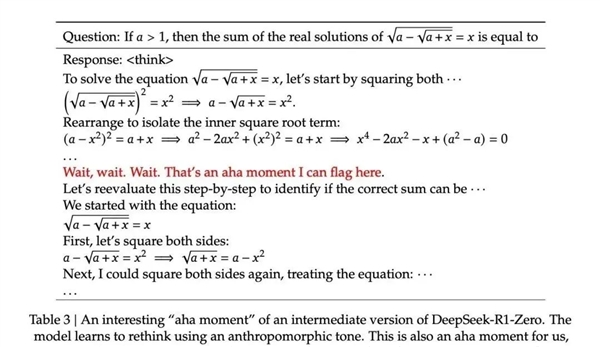

几周前,DeepSeek团队的研究员基于V3版本,仅通过强化学习技术成功研发了R1-Zero版本。近期发布的技术报告显示,Zero版本在训练过程中的进化速度极为迅猛,其性能已迅速接近OpenAI的o1版本,甚至在某些测试项目中,Zero版本的表现超过了o1。

报告指出,模型经历了所谓的“顿悟时刻”。在这一过程中,模型似乎实现了某种领悟。同时,研究人员在目睹此现象时,亦获得了新的认识。这一出人意料的现象极大地提升了研究的探索价值。

“文理双修”诞生R1

凭借R1-Zero卓越的推理根基,DeepSeek团队进一步融入了SFT训练元素,旨在提升模型“口语表达”的技能。经过这一“文武兼备”的修炼,DeepSeek-R1模型正式问世。令人称奇的是,经过优化,R1的推理效能得到了显著增强。

该团队巧妙融合了两种训练方法,此举不仅确保了模型在推理方面的效能,还提升了其与人类沟通的技能,从而显著提升了模型的实际应用价值。

验证技术路线,赋能开发者

测试结果显示,经过R1错题本的学习,Qwen - 7B模型在AIME测试中的通过率达到了55.5%,与参数量多出近5倍的QwQ - 32B - Preview相当。这一结果证实了“小模型搭配优质指导”这一技术路径的有效性。

梁文锋指出,此举不仅拉近了中美两国在AI领域的距离,还使得独立开发者能够训练出能与GPT-4相媲美的AI模型。对于DeepSeek-R1大模型未来的发展潜力,各界看法不一。我们期待在评论区看到您的观点。如文章对您有所启发,请点赞并分享。