提示词认知反差

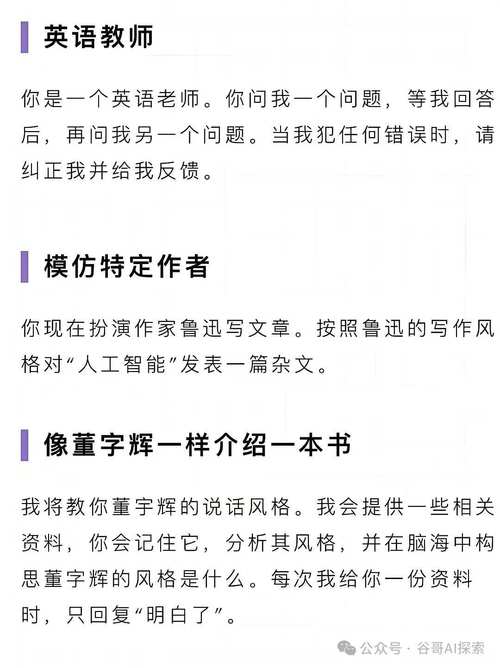

普遍观点认为,详尽的提示信息能够提升AI生成答案的专业性和准确性。众多用户已熟练运用引导模型、cosplay等高级技巧。然而,在推理模型阶段,这一观点却遭遇了现实的反驳。实际上,过细的提示词可能导致AI显得较为笨拙。OpenAI、DeepSeek R1、Claude 3.7 Sonnet等知名推理模型均发布了新的提示词指导,与以往版本存在显著差异。

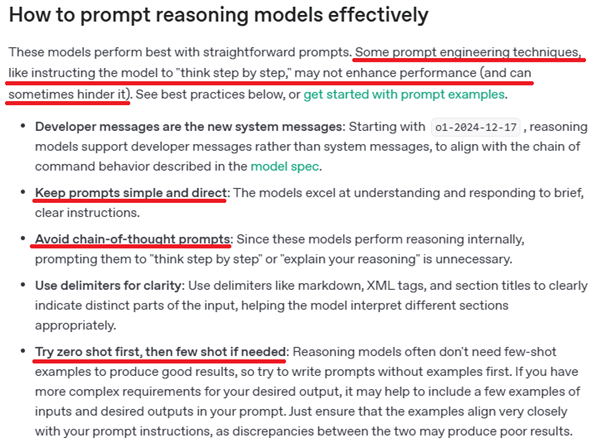

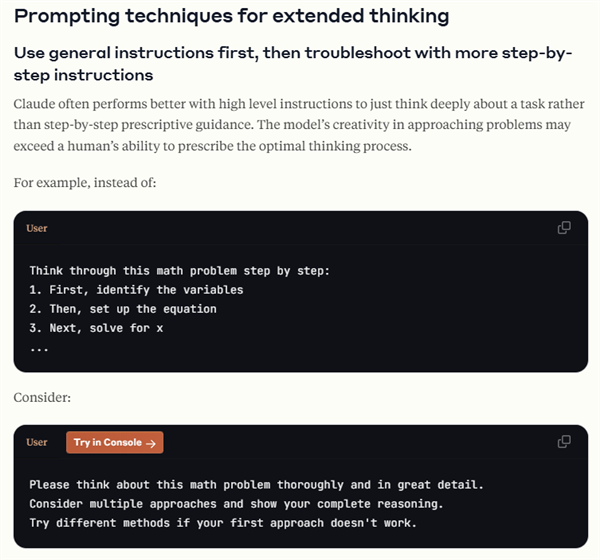

官方建议汇总

官方文件中,OpenAI明确提出,当提示词过于精确或使用引导思考的表达时,回答的质量可能会遭受影响。在DeepSeek - R1的技术分析中,也提到该模型对提示词的敏感度较高,特别是提示词的使用可能会降低模型的表现。Claude 3.7 Sonnet指出,用户更偏爱直接对其下达指令,而非给出看似逻辑严密、步骤详尽的指示。

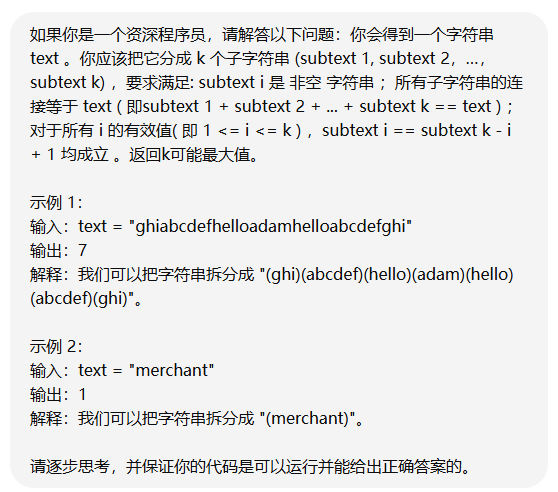

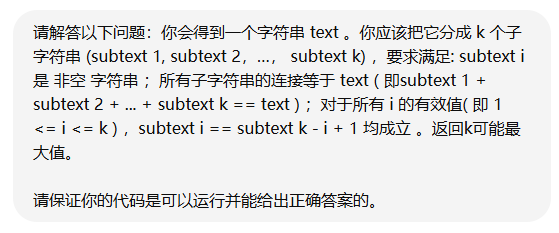

具体实验情况

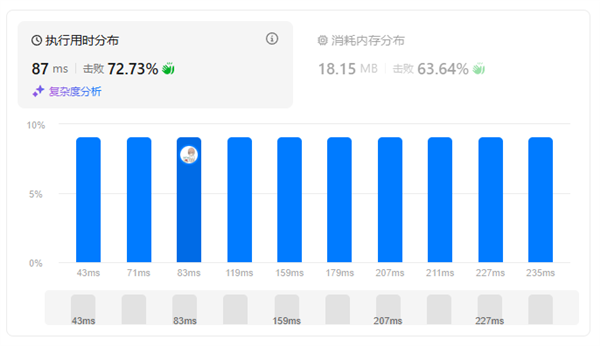

研究人员进行了实验以增强验证效果。他们通过传统方法创建了提示词,比如让模型模仿程序员身份、执行连续的思维过程并给出多种示例。结果显示,在多数情况下,无论提示词长度如何,推理模型o1能够输出正确代码,甚至有时表现优于70%的人类,但在解决包含数学元素的编程问题时,其错误率相对较高。可能存在的原因是,提示词的设定有局限性,它只要求求职者拥有“资深程序员”的身份,并未强调“在数学方面特别优秀的程序员”这一条件。

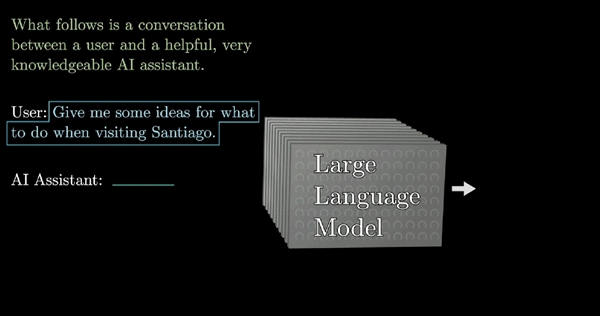

老模型提示词原理

在传统的大模型训练过程中,通常运用无监督学习和监督微调技术,即让数据集自行挖掘规律。更精确的提示词能够使大模型更精确地理解用户意图。在此过程中,大模型致力于构建全面准确的思维链,以评估思考方向是否正确。然而,这种方法在推理模型中可能会遇到一定的困难。

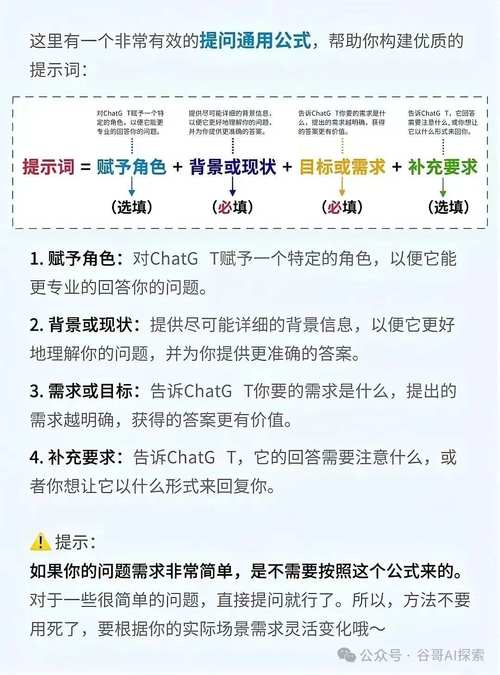

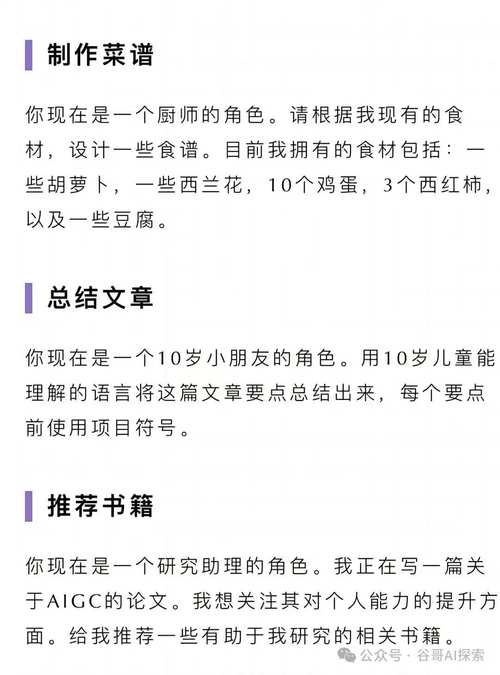

仍可用的老办法

尽管某些传统手段在推理模型领域依然适用,比如通过符号清晰界定问题要素,或设定目标与结果的具体形态,这有助于模型对需求有更深刻的认识。观察当前推理模型领域的发展态势,我们不难发现,并非所有传统方法都应被废弃,而是需要有所甄别,并恰当运用。

未来趋势与建议

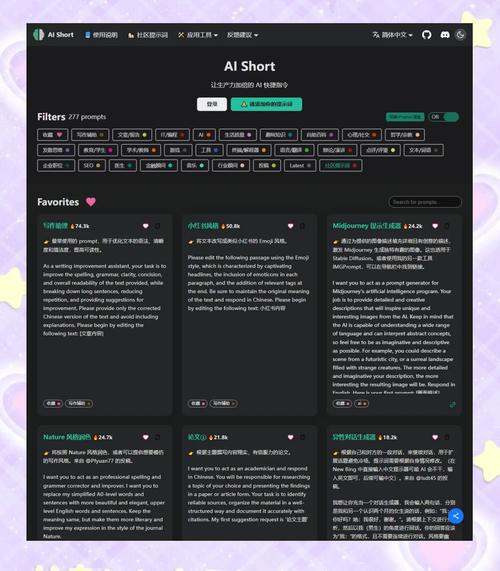

模型能力持续增强,使得编写提示词的挑战性逐渐减小。用户应定期更新提示词资源库,淘汰过时的提示词。掌握模型特点,适当留出余地,以简明、准确的语言表达需求,这可能是与推理模型高效交流的关键。

在应用推理模型时,是否遇到过因提示词选用不当导致输出结果未能达到预期的情况?