近期,位于韩国的知名高等科学技术研究机构KAIST与TB级互联与封装技术实验室TERA,联合对HBM高带宽内存以及AI GPU加速卡在未来十年的发展走向做出了大胆的预测。这一预测迅速引起了广泛的关注和热议,各界人士纷纷对其能否成为现实进行猜测和讨论。

HBM3E现状

目前,HBM技术领域中的HBM3E技术处于行业前沿,并且已经成功应用于实际项目中。NV B300系列和AMD MI350系列均达到了288GB的存储容量,这一容量在市场上属于较高水平。这一容量为众多高性能计算场景提供了坚实的支持。NVIDIA的B300型号的功耗已高达1400W,相比之下,AMD的MI350系列在风冷状态下的功耗为1000W,而在液冷状态下的功耗则攀升至1400W,这两者在运行过程中的功耗都值得特别关注。

即将到来的HBM4

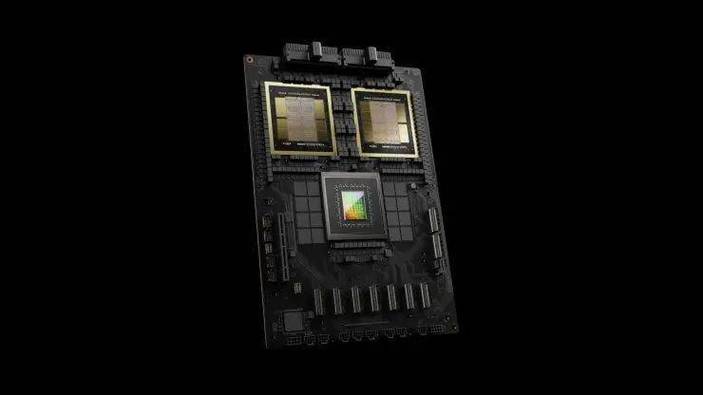

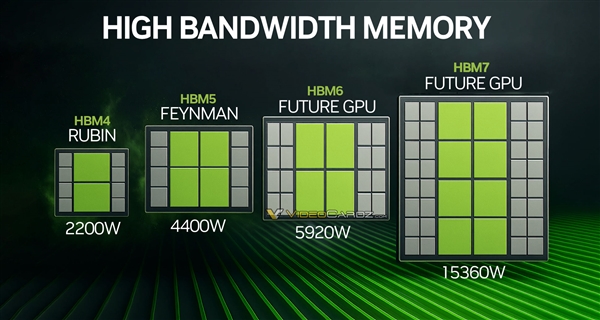

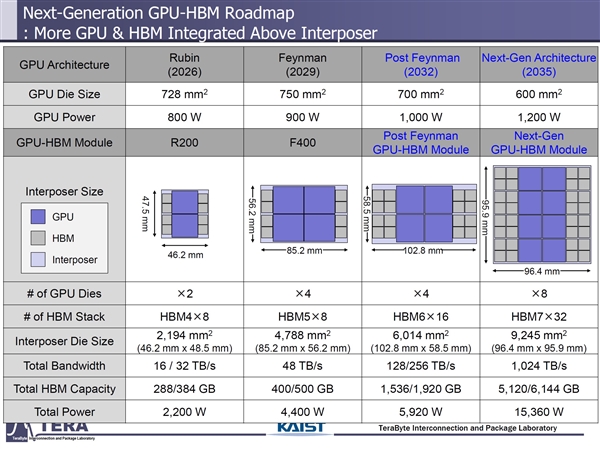

HBM4即将问世,众多厂商对其未来发展方向已有明确计划。NVIDIA推出的Rubin系列预计最大容量将达到384GB,而AMD的MI400系列则展现出更大的雄心,其目标容量设定为432GB。NVIDIA的Rubin型号预计将于明年正式上市,该型号芯片的尺寸为728平方毫米,功耗为800瓦,并采用了双芯集成封装技术。中介层面积约为2200平方毫米,当与8颗HBM4内存协同运作时,其带宽最高可达到32TB/s。预计该卡片整体功耗将为2200瓦。

HBM5、HBM6、HBM7展望

后续HBM标准尚未最终确定,但据预测,其存储容量将迎来显著提升。具体来看,HBM5的容量预计将在400至500GB之间,而HBM6的容量有望达到1536至1920GB,即1.5至1.9TB。至于HBM7,其容量预期将介于5120至6144GB,相当于大约4.2至6TB。存储容量大幅提升,这一变化预计能够有效满足人工智能、大数据等多个领域对数据存储需求的急剧增长。

代号Feyman的NVIDIA AI GPU

代号Feyman的NVIDIA AI GPU的新版本预计在2029年推出,其核心尺寸约为750平方毫米,功耗预计约为900瓦。该芯片运用了四芯集成封装技术,中介层面积大约为4800平方毫米,同时配备了8颗HBM5内存,带宽达到了48TB/s,整个GPU的功耗大约为4400瓦。那时,其性能有望显著增强;与此同时,功耗问题也将愈发显著。

2032年新品设想

2032年,新一代产品有望推出,继Feyman系列之后,该系列的新产品即将上市。该产品的单芯片尺寸大幅缩小,降至700平方毫米。与此同时,其功耗实现了显著提升,突破至1000W以上。借助四芯集成封装技术,中介层的面积超过了6000平方毫米。除此之外,该产品还搭载了多达16颗HBM6内存芯片,其带宽更是高达256TB/s。该设备的整体功耗达到约6000瓦。随着性能与存储容量的不断加强,功耗与芯片尺寸之间的冲突似乎愈发难以解决。

2035年产品预期

到2035年,新一代单片芯片的体积将缩小至600平方毫米,但能耗将增加到1200瓦。同时,该产品将采用八芯片集成封装技术,中介层的面积将超过9000平方毫米。与之配套的是32颗HBM7内存,其数据传输带宽可达1TB/s,功耗更是达到了15000瓦。随着这一趋势的发展,数据中心或许确实有必要安装一座核电站,以确保其能源供应的充足性。

当前的发展速度如此之快,能源消耗需求也极为巨大,这样的模式是否真的可行?关于未来,我们是否能够有效应对高带宽内存和AI GPU加速卡在能耗方面所面临的挑战?欢迎在评论区分享您的观点,并请记得点赞和分享本文。