“那我问你”梗爆火

近期,“那我问你”这一网络流行语迅速走红,众多网民纷纷模仿并制作相关视频,吸引了大量关注。这种新颖的表达方式和独特的视频风格,在社交平台上引发了广泛传播热潮,众多网民因其趣味性和传播力而深受吸引。

理想版“那我问你”诞生

在“那我问你”这一梗流行之际,理想汽车的相关话题也迅速升温。一些理想汽车的粉丝运用人工智能技术,制作了李想版“那我问你”的视频内容。在这些视频中,李想化身为“小明剑魔”,向对理想汽车技术提出质疑的观众连续发问。这些反问句与理想汽车的实际技术亮点相结合,诸如95%的全车自研率、集成语音导航的辅助驾驶系统等,在网络上引发了新一轮的热烈讨论。

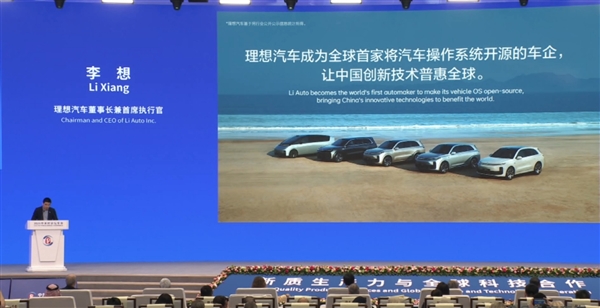

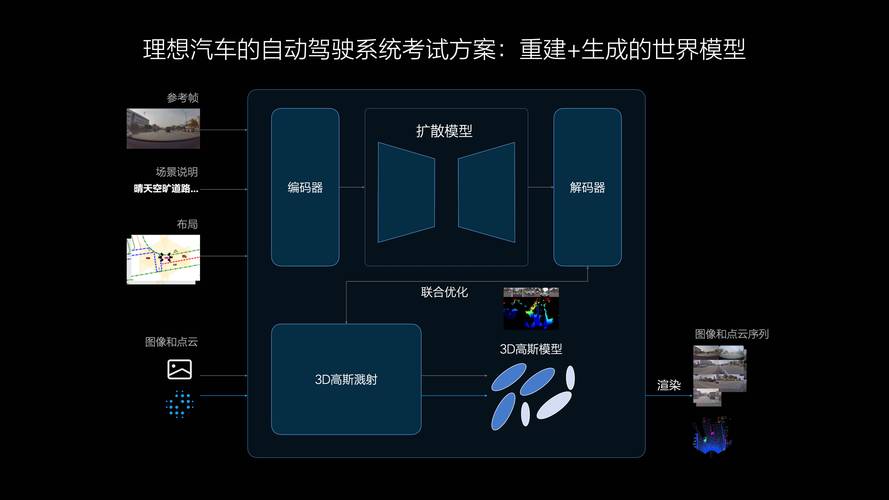

NVIDIA GTC 2025理想新发布

2025年3月18日,在NVIDIA GTC 2025大会上,理想汽车发布了全新自动驾驶技术MindVLA。该技术融合了视觉、语言和行为等多方面功能,被命名为“机器人大模型”。MindVLA综合了空间智能、语言智能和行为智能,目标是将汽车从传统交通工具升级为“贴心的专职司机”。此举标志着理想汽车向L4级自动驾驶迈出了重要步伐。

MindVLA“听得懂”能力

MindVLA具备出色的语言分析能力。用户可利用语音指令来改变车辆的行驶路线和行为。即便是在缺乏导航信息的陌生区域,只要用户说出“前往超市”,MindVLA也能自动引导车辆到达指定地点。行驶途中,若用户提出“速度过快”或“应走左侧道路”等指示,MindVLA也能精准识别并执行。

MindVLA“看得见”优势

该系统拥有出色的通用识别功能,能准确识别星巴克、肯德基等知名品牌的标志。在用户异地寻找车辆遇到困难时,只需拍摄周围环境照片并发送给车辆,车辆便能根据照片定位并自行前往用户所在地。这一功能通过模型对环境进行感知和分析,极大地增强了使用的便捷性。

MindVLA“找得到”特点

在MindVLA技术的支持下,车辆能够在地下车库、园区和公共道路上自如行驶。当商场地下车库车位吃紧时,只需发出“寻找并泊车”的指令,车辆便能自主搜寻空位。即便陷入死胡同,它也能倒车并继续寻找,整个操作过程不依赖地图或导航,完全凭借其空间感知与逻辑判断能力完成。MindVLA技术已成功完成工程化适配,预计在2026年将应用于量产车型。此架构未来有望在非驾驶场景,例如室内空间,得到应用,并推动通用人工智能的发展。关于理想汽车的自动驾驶技术,您认为它是否有望引领行业的新动向?